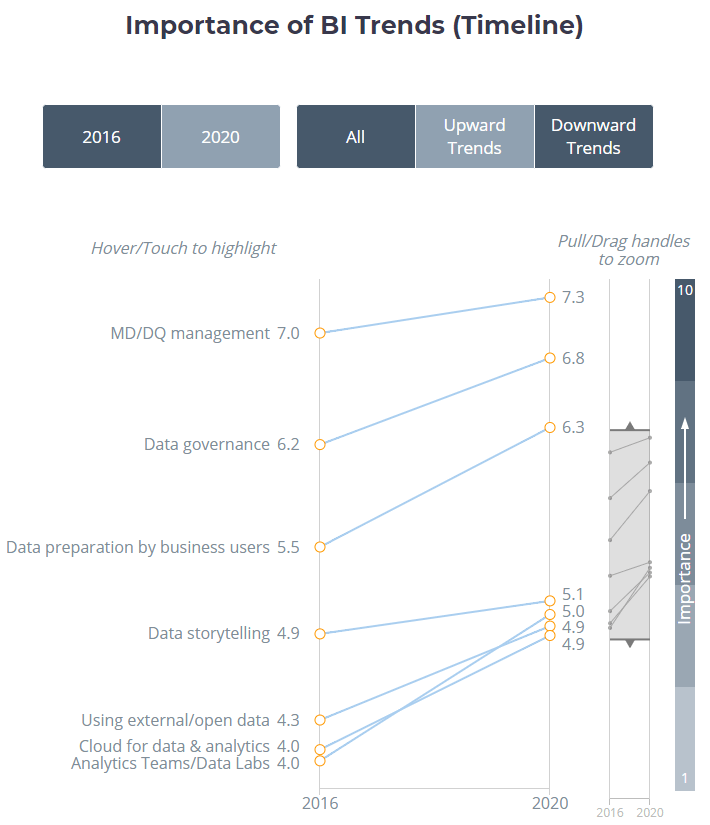

Diverse ricerche mostrano come la gestione della qualità del dato (o Data Quality Management, DQM e Master Data Management, MDM) è – e sarà per il prossimo biennio – il trend principale in ambito Business Intelligence e Analytics attraverso il quale si potrà sfruttare a pieno il valore intrinseco dei dati a disposizione, trattandoli come vero e proprio asset strategico aziendale. Il tema è di interesse per tutte le aziende e, in particolare, per quelle nativamente non digitali che, spesso, hanno subito fusioni o riorganizzazioni tecnologiche interne, che poggiano su sistemi legacy difficili da dismettere e che si ritrovano a rincorrere startup e cosiddette digital companies alla guida del mercato in questa direzione.

Integrare nelle funzioni aziendali anche quella del DQM si riflette quindi in maniera sostanziale in termine di ritorno sull’investimento in ambito dati, non solo dal punto di vista monetario ma anche dal punto di vista del tempo delle risorse aziendali.

Fig 1. Trending BI topics (BIsurvey.com)

Data Quality per generare valore

Esistono svariate definizioni di Data Quality che, provando a darne una connotazione concreta e contestualizzata ai sistemi di Business Intelligence (BI), si può riassumere come il livello di capacità che hanno i dati in nostro possesso di poter essere prontamente utilizzati ed effettivamente utili agli scopi aziendali ricavandone quindi un concreto guadagno. Questo guadagno può essere di diverso tipo e, premettendo che i dati generano comunque un valore spesso intangibile o comunque difficilmente stimabile, parleremo generalmente di “valore” che i dati possono portare all’azienda.

Culturale: una recente ricerca condotta da Marketing Charts evidenzia che il 78% delle aziende considera come un problema i propri debiti tecnici relativi a dati, mentre il 40% degli esperti di business aziendale non ha fiducia nei dati messi a disposizione dai sistemi di BI. Questo pone un freno alla digital transformation e mantiene gli utenti legati a vecchie piattaforme legacy o a fogli Excel destrutturati dove la conoscenza aziendale non è trasferita a sistema ma rimane legata alle persone. Una buona Data Quality porta con sé anche un cambio di mindset da parte del personale che diventa più fiducioso e promuove la cultura dei dati in azienda.

Tempo: la stragrande maggioranza del tempo nella gestione del dato è dedicata alla sua riconciliazione, pulizia e correzione. Si stima che le figure professionalmente più ricercate dell’ultimo periodo, i Data Scientist, dedichino in media l’80% del loro tempo alla data preparation e alla loro pulizia, tempo che invece, con una appropriata qualità del dato a disposizione, potrebbe essere dedicato ad attività a più alto valore aggiunto come l’analisi del dato stesso o lo studio e creazione di algoritmi.

Economico: principalmente dato da cost-saving derivante dalla riduzione del tempo e delle inefficienze dovute alla gestione di una cattiva qualità del dato. Ricerche condotte da Gartner e IBM hanno stimato per il 2018 rispettivamente in 9,7 milioni di dollari in media e 3,1 trilioni di dollari per l’intero mercato americano le spese derivanti da una scarsa Data Quality.

Non esiste una misura assoluta – una sola “capacità”, come è stata definita in precedenza – di qualità del dato; questa può e deve essere valutata secondo differenti assi.

Dato che anche tra i professionisti stessi della Data Quality non tutte le dimensioni chiave -quelle classiche che si trovano in letteratura: accuracy, consistency, integrity, completeness, timeliness – sono universalmente condivise, non verranno approfondite.

È proprio questo l’aspetto che si deve quindi tenere in considerazione: essendo la Data Quality una materia complessa e fortemente legata al contesto, risulta a maggior ragione strategicamente importante integrare esperti di DQ in azienda che, insieme agli end users, definiranno quelle che sono le regole o, meglio, i requisiti chiave su cui valutare la qualità del dato, secondo i principali use case.

Data Quality Management

La DQM è una delle principali componenti del più ampio concetto di Enterprise Data Management, nel quale sono incluse tematiche come la Data Governance e la Data Architecture. Essa concentra in sé tutti i processi, le persone e le tecnologie che si pongono come obiettivo il raggiungimento del più alto livello di Data Quality, coinvolgendo non solo i reparti IT ma anche il Business. L’importanza per un’azienda di dotarsi di sistemi DQM e MDM si manifesta soprattutto in contesti in cui un’insufficiente qualità e pulizia del dato può risultare inutile se non dannosa. Questo è molto evidente in contesti quali sistemi di Internet Of Things, ad esempio nella guida autonoma, in ambito medico o nella manutenzione predittiva nell’industria manifatturiera.

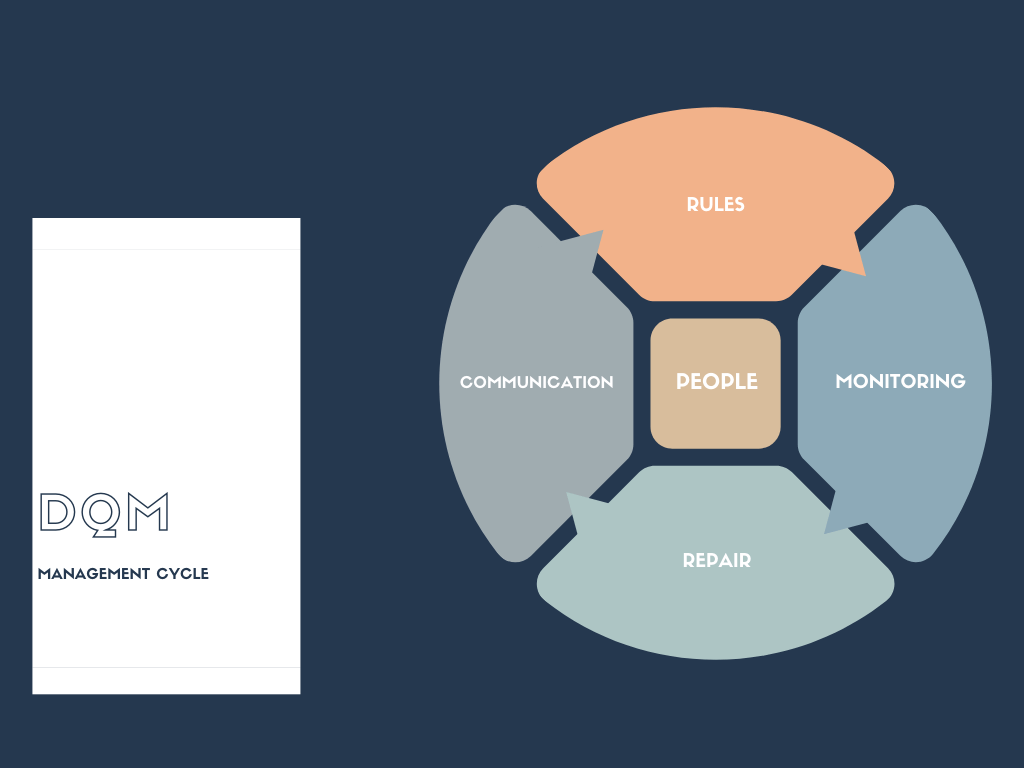

Analizziamo quindi quelli che sono principali componenti che una company dovrà curare per poter mettere in piedi una robusta gestione della qualità dei dati.

People

Occorre individuare diverse figure di riferimento per poter diffondere la vision aziendale ponendo il focus sulla strategicità del dato, della sua consistenza e, a seguire, la corretta applicazione dei principi di DQM nelle attività di sviluppo come, ad esempio, in fase di ETL (Extraction Transformation Load) e di modellazione del dato per i sistemi di BI

Rules

La qualità stessa è uno dei pillar intrinsechi della DQM. Partendo da quelli che sono i requisiti business e gli obiettivi aziendali, occorre definire le regole con le quali si devono gestire i diversi tipi di problemi che si possono incontrare nelle fasi di sviluppo. Queste regole non saranno scritte nella pietra ma, in maniera iterativa, dovranno essere adattate in seguito al monitoraggio sulla loro applicazione o in risposta a cambiamenti dei requisiti business

Monitoring

Quello che deve assumere un ruolo sempre più importante è un costante e critico reporting di monitoraggio del livello di qualità del dato. Spesso sottovalutati o ritenuti poco utili, i report di auditing degli errori, così come quelli delle performance (ordini, spedizioni, budget,…), devono entrare necessariamente nel dashboarding enterprise che viene implementato tramite strumenti di BI

Repair

Al verificarsi di un errore, è di vitale importanza una prima fase di triage per poter individuare ed esaminare la “root-cause”, sorgente dell’errore. Se fatto in maniera olistica, questo step permette di poter azionare gli interventi di riparazione ed eventualmente di revisione delle regole che erano state precedentemente pensate

Communication

Spesso dimenticato, questo aspetto è quanto mai importante. In aziende mediamente grandi e con importanti stratificazioni, la giusta comunicazione e il “saper vendere” le iniziative di DQM evidenziandone i benefici, così come comunicare a dovere gli interventi di miglioramento applicati è buona prassi per poter aumentare la fiducia del personale nei dati aziendali

Applicazione aziendale di DQM

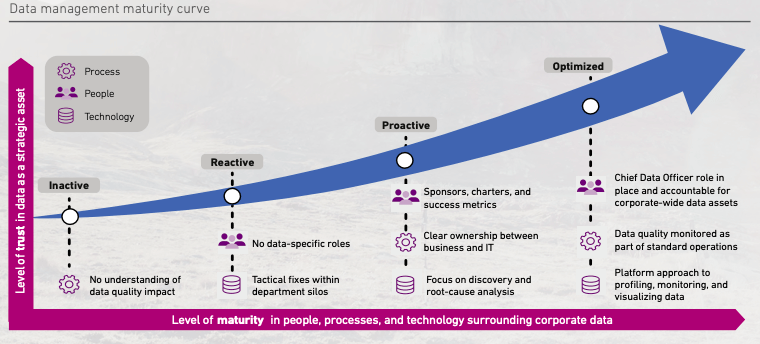

Per poter applicare quanto detto, è importante pianificare l’introduzione di funzioni dedite alla gestione e monitoraggio della data quality e alla definizione dei requisiti di base. Valutare la situazione attuale e gli interventi per poter rendere i processi conformi a tali requisiti, integrando in maniera organica all’interno della propria organizzazione, è quindi il passo successivo per poter iniziare a monitorare e valutare i benefici. Questo permette di poter accrescere il livello di maturità della nostra azienda, la sua robustezza e flessibilità davanti a situazioni di errori o problematiche derivanti direttamente o indirettamente da una cattiva qualità del dato.

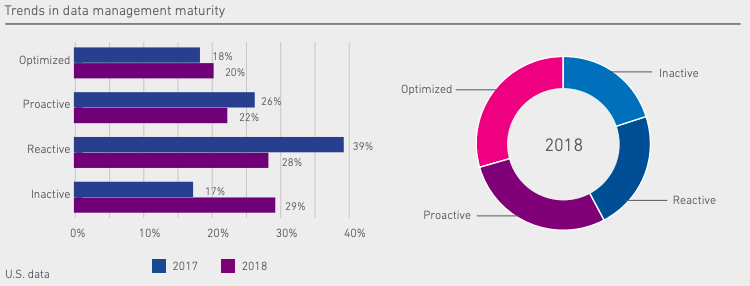

Secondo una stima del 2019, il 58% delle aziende non ha un’adeguata pianificazione per la gestione della qualità del dato, il che porta ad avere al massimo qualche azione di tipo reattivo al presentarsi di data quality issues o, peggio ancora, a non avere nessun tipo di gestione di queste problematiche.

Fig 2. Approccio alla DQM (Experian – Global Data Management Report)

Affinché ci si possa muovere verso un approccio proattivo alla gestione delle questioni derivanti da una cattiva qualità del dato, esistono diverse azioni dipendenti, anche, dal tipo di area di business nel quale l’azienda si trova. Alcune linee guida generali sono:

- Porre alti standard di controllo qualità agli “entry point” sui sistemi sorgente; il che risulta molto meno costoso e permette di prevenire problemi nei sistemi a valle (come strumenti di BI ad esempio)

- Identificare e prioritizzare le principali aree di appartenenza del dato. Concentrarsi su porzioni di dato business critical permette di essere pareto efficienti, considerati vincoli di tempo e budget (tipicamente il 20% dei problemi causa l’80% dei mal di pancia)

- Compiere critiche analisi di triage e root cause analysis per far sì che la correzione di un errore non ne generi un altro oppure che con un singolo intervento se ne possano risolvere diversi

- Raccogliere tutte le problematiche e le informazioni ad esse associate (cause, sorgenti, costi, pattern,…) in un repository centralizzato per tracciare e “profilare”; questo risulta essere utile per affrontare eventuali questioni future, in modo da individuare eventuali pattern

Fig 3. Curva di maturità nel DQM (Experian – Global Data Management Report)

Sorgenti di una bassa Data Quality

Elencate quelle che sono le fondamenta per approcciare adeguatamente il DQM è utile conoscere quelli che risultano le principali sorgenti che causano problemi in termini di qualità del dato

- Fusioni e acquisizioni: risulta molto probabile – se non quasi certo – che una compagnia che si fonde o che viene rilevata usi uno stack dati completamente differente, diversi metodi/tecnologie di integrazione del dato oppure semplicemente abbia dati di bassa qualità (siano essi incompleti, inconsistenti,…)

- Migrazioni da sistemi legacy: muoversi da vecchi sistemi verso altre tecnologie porta con sé inevitabilmente svariati ostacoli. Per citarne un paio dei più impattanti, il formato in cui i dati devono essere strutturati per poter essere utilizzati da una tecnologia diversa – aspetto tutt’altro che banale da gestire – o la replica delle regole di business per poter garantire la consistenza del dato

- ETL: il cuore dei sistemi di BI, la parte di processamento del dato costituisce una fase nevralgica in cui possono nascere problematiche a implementazioni non ottimali, poco flessibili: se non vengono applicati i corretti paradigmi di programmazione/modellazione – accompagnati da una appropriata documentazione – si rischia di dover inseguire continuamente bug o debiti tecnici con workaround, “mettere una pezza” o con rework massivi (che costano molto tempo)

- Errori manuali: tipicamente sono la causa principale della cattiva qualità del dato. È per questo che sistemi di DQM, non solo devono prevedere azioni tecnologiche per ridurre al minimo l’incorrere di questi errori – o a intercettarli per tempo -, ma anche da sessioni di formazione dedicate

Conclusioni

È indubbio come questo periodo storico abbia dato – semmai ce ne fosse stato bisogno – ulteriore consapevolezza e visione al mondo dell’importanza strategica dei dati per guidare le scelte, non solo dei singoli individui e delle aziende, ma anche di intere nazioni. Nel bene e nel male, proprio in risposta alla crescente necessità di saperne di più di quello che significa l’impatto del COVID-19 nel mondo, abbiamo sempre più bisogno di numeri e delle informazioni che da essi se ne ricavano.

Il “dato”, sempre più integrato nel tessuto organizzativo, deve essere considerato un asset e come tale deve essere trattato: è una materia prima che necessita di essere controllata e lavorata rispettando standard imposti dal mercato e dall’azienda, isolando le componenti mancanti o difettose e agendo per il loro recupero/riqualificazione, così da poter avere una risorsa di valore e utilizzarla come carburante per alimentare la trasformazione verso il digitale e supportarne le diverse funzioni. È opportuno creare validi casi d’uso che facciano da volano per poter ricevere sponsorizzazioni anche lato business e avviare progetti più ampi di DQM. Individuando requisiti di qualità che devono essere soddisfatti, persone di riferimento per poterne monitorare i processi, abbandonando vecchi metodi per la gestione dei dati, sono solo i primi step. La Data Quality Management è una maratona, non uno sprint, ed è necessario impegnarsi nella sua applicazione non come esercizio una tantum, ma come processo iterativo, per diventare un’area di operation aziendale, al pari di tutte le altre.