Alla luce della costante e rapida evoluzione del panorama tecnologico e informativo degli ultimi anni, è comune porsi la questione di una più snella integrazione di reportistiche efficaci attraverso le quali sfruttare sorgenti dati certificate e abilità analitiche di specialisti di dominio senza dover necessariamente sottostare ai tempi tecnici e alla rigidità del reparto IT. Questo processo guidato da utenti di business e regolato da un’opportuna governance centralizzata permette di affiancare strumenti di Business intelligence classici a tecnologie di Data discovery/Data visualization, per ottenere suggerimenti ad alto valore aggiunto in tempi più brevi. Nell’era dei big data questi approcci sono essenziali per sfruttare al meglio l’ammontare di informazioni a disposizione al fine di prendere decisioni sempre più data-driven.

Data discovery e Data visualization

Il processo di Data discovery permette di individuare in maniera rapida ed efficace pattern, trend, outliers (valori fuori norma) e altre evidenze di rilievo che difficilmente sarebbero visualizzabili con strumenti di reportistica classici. Alla sua base risiedono i principi di Data visualization che sfruttano particolari rappresentazioni visuali – grafici avanzati, mappe, diagrammi – utili a evidenziare questi fenomeni.

In estrema sintesi, i processi di Data discovery si compongono di due fasi:

- la prima concerne la preparazione del dato e richiede conoscenze base di modellazione per renderlo utilizzabile ai fini della visualizzazione e per assicurare che le informazioni mostrate siano corrette. In questa fase è possibile connettere dati aziendali strutturati con sorgenti dati esterne come fogli Excel, feed da tool di Web Analytics, Open Data e così via

- la seconda fase, invece, riguarda la sua visualizzazione, ovvero la vera e propria “costruzione” delle analisi visuali che facilitano l’utilizzatore a individuare eventuali caratteristiche di interesse supportandolo nel decision-making. I più diffusi tool di Data discovery si sono evoluti grazie all’integrazione di funzioni statistiche (regressione, clustering,…) e suggerimenti automatizzati per supportare l’individuazione di potenziali problematiche

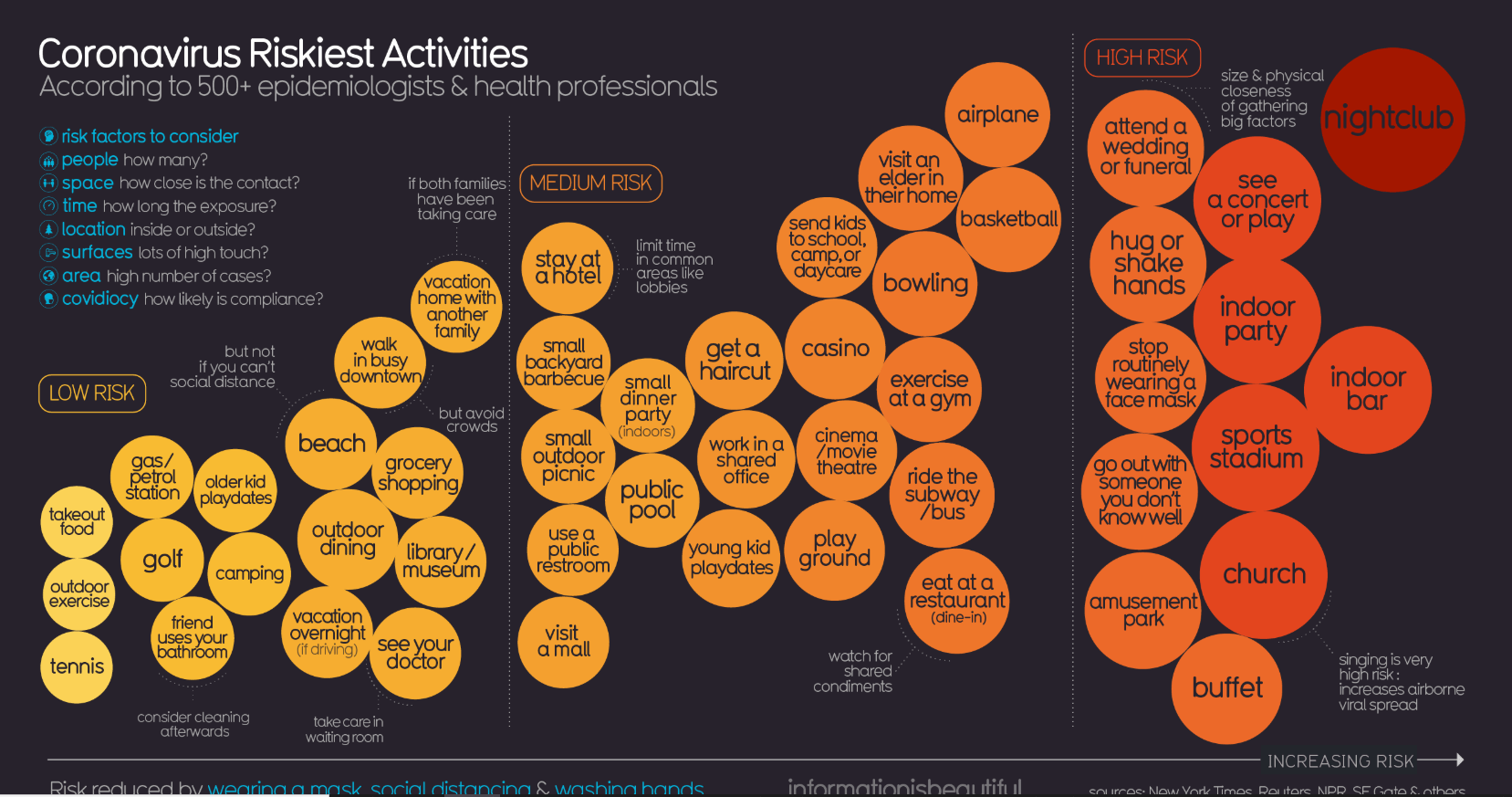

Data discovery e Data visualization sono due mondi interconnessi. Si pensi, ad esempio, come il moderno Data journalism e il cosiddetto Data storytelling sfruttano le più efficaci teorie di visualizzazione dell’informazione per poter comunicare messaggi di diversa natura (dal livello di rischio di contagio tra le diverse attività sociali al racconto di anni di guerra in Siria e le loro conseguenze al patrimonio culturale).

Fig 1. Attività per livello di rischio di contagio al COVID-19

Fig 2. Data Storytelling

(Fonte https://www.corriere.it/reportages/esteri/2017/guerra-siria-danni-collaterali/desktop.html)

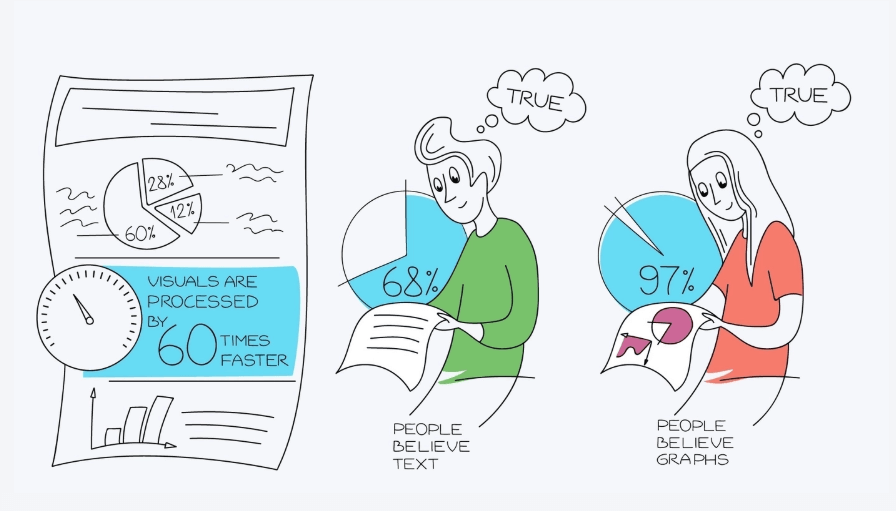

La Data visualization è in parte arte e in parte scienza; quest’ultima componente deriva dalla natura stessa dell’uomo e dalla sua evoluzione, una evoluzione prevalentemente visiva. La vista è il nostro senso più potente e il canale più efficiente per ricevere informazioni. Il 70% dei recettori sensoriali del nostro corpo, infatti, è dedicato alla vista. Dal momento che le rappresentazioni tabellari si affidano in gran parte al linguaggio verbale in forma di testo scritto, l’efficacia della loro percezione visiva è ridotta, contrariamente a quella dei grafici che hanno, invece, una natura prevalentemente visiva.

Esistono tre differenti tipi di memoria che il cervello utilizza per processare le immagini:

- la memoria iconica che, inconscia, processa l’informazione in maniera estremamente rapida e si occupa di passare le informazioni che ritiene più rilevanti

- quella meccanica, che, attraverso i pezzi di informazione passati dalla memoria iconica, processa associazioni e ragionamenti

- infine, quella a lungo termine, che decide se e quali informazioni memorizzate per utilizzi futuri

L’obiettivo di una buona struttura e delle giuste modalità con cui il dato viene presentato è quello di “far breccia” nella memoria iconica in modo tale che l’individuazione di determinati fenomeni diventi sempre più istintivo. Questo tipo di memoria è particolarmente sensibile ad attributi visuali quali il colore, la sua intensità, i contrasti, la posizione degli oggetti nello spazio e la loro forma. Lungo questi assi si gioca la partita di una efficace Data visualization.

Ciò fa sì che le immagini e informazioni fortemente visive vengano registrate molto più velocemente e che, come sostengono diversi studi a riguardo, vengano addirittura considerate più veritiere rispetto alla loro versione testuale.

Fig 3. Efficacia della visualizzazione

La Data visualization, dunque, è un aspetto che non si ferma alla mera rappresentazione grafica.

Come riportato da Colin Ware in Information Visualization: Perception for design, “il sistema visivo ha le proprie regole, possiamo facilmente riconoscere pattern presentati in determinate maniere ma, se presentate diversamente, queste diventano invisibili. Se si comprende come funzionano le regole legate alla percezione visiva umana, i dati possono essere rappresentati in modo che certi fenomeni vengano catturati istantaneamente. Se queste regole non vengono rispettate, di contro, possono essere prodotti risultati incomprensibili ,o peggio, ingannevoli”.

Vantaggi e potenziali problematiche di Data discovery

La società di consulenza strategica e ricerche Gartner, in uno dei suoi report annuali (analisi molto influenti nel mondo della Business intelligence e degli analytics), ha dichiarato che il 2016 ha segnato un punto di svolta nel processo di distacco da una struttura dell’analisi dei dati IT-centrica, per muoversi verso servizi più moderni di self service Data discovery a vantaggio degli utenti finali.

Questa evoluzione metodologica porta particolare beneficio ad aspetti per i quali i sistemi tradizionali di Business intelligence sono, storicamente, meno adeguati:

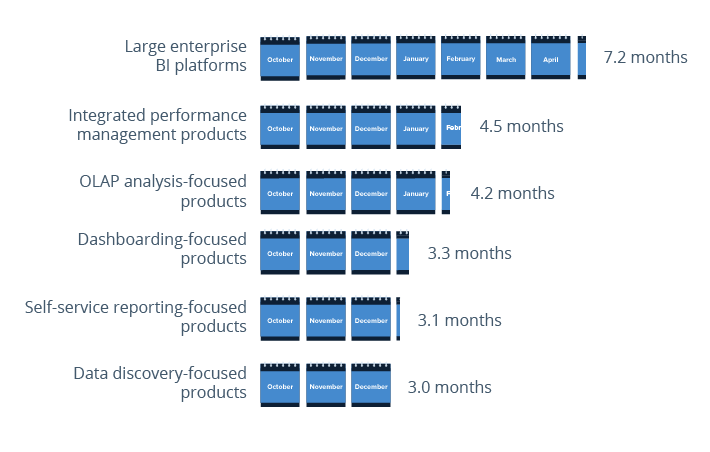

- Time to Market: iniziative di Data discovery non necessitano di un modello dati precostruito e hanno solitamente minori costi di upfront; di conseguenza il supporto da parte del personale IT è minimo. Per questo sono molto competitive dal punto di vista del tempo che i loro prodotti impiegano per diventare effettivamente fruibili dagli utenti finali

Fig 4. Time to market medio per iniziative IT

- Rapid Prototyping: spesso, quando si vogliono introdurre nuove analisi in azienda, vi è l’esigenza di elaborare dei Proof of Concept per valutarne la fattibilità. Tecnologie di Data discovery permettono di implementare questi semilavorati e raffinarli successivamente in maniera agile ed efficiente

- Modellazione dati: la modellazione dei metadati è sicuramente il punto di forza dei sistemi di BI tradizionali. Una volta definiti, però, sono piuttosto rigidi e costosi da modificare, in particolar modo se le modifiche da applicare riguardano cambi strutturali o di logiche di business. Con strumenti di Data discovery, non esistendo un vero e proprio modello dati -o c’è, anche se basilare – questa tipologia di modifiche richiede tempistiche più ridotte.

- User Interface: la BI fornisce un set potente ed esaustivo di funzionalità per strutturare il dato ed esporlo, ma non si può dire che brillino dal punto di vista dell’interfaccia grafica e della semplicità di utilizzo. Per questo motivo il “lavorare il dato” fino a pochi anni fa era una materia esclusivamente rivolta a sviluppatori specializzati. Tool di Data discovery e Data visualization invece fanno della user friendliness il loro principale punto di forza; il che permette di ampliare ad un’audience più ampia attività come la preparazione di report e dashboard

Anche se non possiamo negare che tutti questi aspetti sono di grande valore, è importante non perdere il focus su quello che rappresenta strategicamente la reportistica enterprise messa a disposizione da strumenti di Business intelligence e analytics.

Di fatto, occorre tenere presente le criticità che questa nuova modalità di fruizione del dato può generare:

- Analisi che hanno il medesimo scopo, fatte da team di analisti diversi che condividono un certo perimetro dati, possono potenzialmente applicare diverse logiche e quindi generare risultati discordanti. Queste analisi, dette “a silos”, sono il rischio più concreto a seguito dell’espansione di strumenti di self service Data discovery.

- Osservazioni condotte da certi dipartimenti possono risultare effettivamente efficaci ma impossibili da replicare su scala enterprise, poiché necessiterebbero di una complessa e più strutturata modellazione per poter entrare a far parte della reportistica aziendale.

- Con la diffusione delle tecnologie di Data discovery tra diversi team (eserciti di analisti che lavorano sulle stesse sorgenti) il rischio è quello di ricreare l’esperienza che iniziative di Business intelligence propongono di eliminare: ovvero l’incontrollata proliferazione di decine/centinaia di analisi ad-hoc che viaggiano da una scrivania all’altra proprio come succedeva – e purtroppo continua a succedere – con fogli Excel

Integrazione con sistemi di Business intelligence

Gli evidenti vantaggi apportati da questi nuovi strumenti e approcci al consumo del dato, tuttavia, non devono portare a credere le aziende si debbano ritrovare scegliere tra una tipologia “old style” e una più moderna. Come quasi tutti gli aspetti tecnologici, anche questo tipo di scelte dipende dal contesto e dagli obiettivi che ci si pone; di certo non si tratta di una scelta mutualmente esclusiva, anzi, ormai è prassi avere entrambi gli strumenti per ampliare l’offerta di reportistica interna.

In risposta a questo aspetto, i maggiori vendor di tecnologie di BI, riconoscendo l’impatto e i vantaggi discussi finora, stanno cercando di tenere il passo includendo nelle loro offerte funzionalità di Discovery/Visualization che si integrino agilmente con strumenti classici, facendo leva su una più rapida integrazione dei due mondi (si veda ad esempio Microstrategy Desktop o Oracle Analytics).

L’integrazione in azienda di questi strumenti dovrà essere fatta anche in accordo con quelle che sono le persone a cui verrà dato accesso. Individuare in anticipo key users e business analyst che saranno il punto di riferimento ed educarli a un trattamento opportuno dei dati aziendali (la Data governance riconosce queste come attività fondamentali) è la chiave per aumentare le possibilità che l’adozione di questi tool porti contributi significativi.

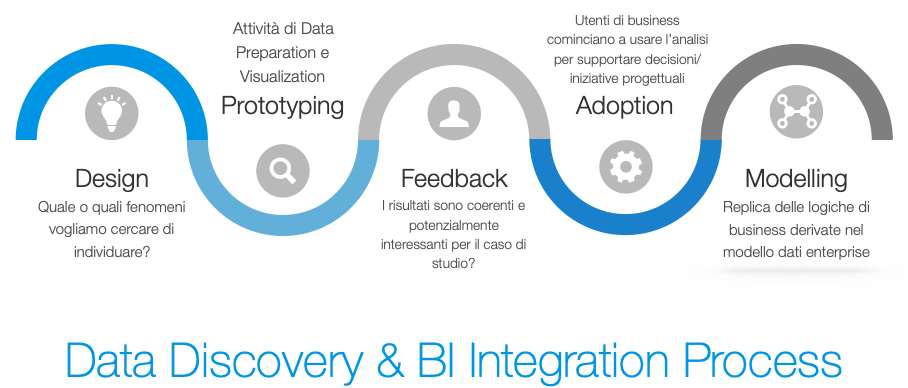

Il processo di adozione di questa metodologia di analisi, per essere sano, dovrà prevedere una prima fase di prototipazione, dove le visualizzazioni prodotte verranno valutate ed eventualmente raffinate per:

- generare risultati estemporanei (per decisioni una tantum, ad esempio) e venire dunque dismesse, oppure

- diventare un vero e proprio prodotto di riferimento per uno o più reparti (o addirittura per l’intera azienda)

Infine, se le visualizzazioni, i KPI (Key Performance Indicator) e le logiche di business che sono state create o sono emerse durante l’attività di Data discovery, verranno considerate di valore strategico per l’azienda, allora si potrà passare a un’opera di consolidamento nella quale quanto generato, venga integrato nel modello dati tradizionale ed eventualmente fruito via reportistica BI. Questo è il vero e proprio punto di contatto tra i due mondi.

Conclusioni

I sistemi di Business intelligence sono ritenuti oggigiorno una commodity da quasi tutte le aziende. Ciò non toglie che questi riescano a rispondere alle crescenti esigenze di analisi che derivano dalla bulimia di dati che le sta investendo. Per poter gestire questo flusso di nuove informazioni di diversa natura in maniera snella, in modo da capire rapidamente se sono valevoli di entrare nel patrimonio informativo della nostra organizzazione, strumenti e processi di Data discovery e Data visualization devono essere adottati per affiancare e completare i metodi più classici, eventualmente arricchendoli.

Per evitare l’uso destrutturato di questi strumenti è altrettanto fondamentale che vengano scelte le giuste persone e che queste operino in linea con mirate politiche di Data governance in modo da assicurare consistenza di standard e logiche di business per poterne trarre il maggior beneficio. Solo in questo modo la Data discovery può diventare una leva per portare il massimo vantaggio competitivo dai dati in nostro possesso e non un’ulteriore fonte di problemi da gestire.