Anche il 2018 si conferma un anno di crescita per il mercato dei Big Data Analytics in Italia. Le organizzazioni hanno compreso il potenziale delle opportunità strategiche offerte dai dati e proseguono il percorso di trasformazione verso il concetto di data driven company. Sulla scorta di queste evoluzioni in atto, le aziende risultano più pronte rispetto al passato e riescono ad offrire risposte più rapide alle richieste del business aziendale.

La nuova sfida diventa quella di adottare soluzioni Fast & Smart: da una parte, in grado di analizzare i dati in tempo reale integrando diverse fonti informative in streaming e rispondere velocemente alle esigenze del business; dall’altra parte, basate su meccanismi di apprendimento intelligente, Machine Learning e Deep Learning, che identificano pattern e correlazioni presenti nei dati e trasformano questa conoscenza in azioni concrete che permettono alle imprese di acquisire un vantaggio competitivo.

L’Osservatorio Big Data Analytics & Business Intelligence, promosso dalla School of Management del Politecnico di Milano, intende monitorare il valore strategico che le metodologie di Analytics svolgono nelle imprese, stimarne il mercato e mettere in luce casi di successo e aree di maggior impatto per le organizzazioni.

La ricerca ha coinvolto attraverso una survey oltre 600 CIO, Responsabili IT e Responsabili Analytics di piccole, medie e grandi aziende utilizzatrici e, tramite interviste dirette o fonti secondarie, i principali player dell’offerta.

Un mercato sempre più concreto ma non maturo per le PMI

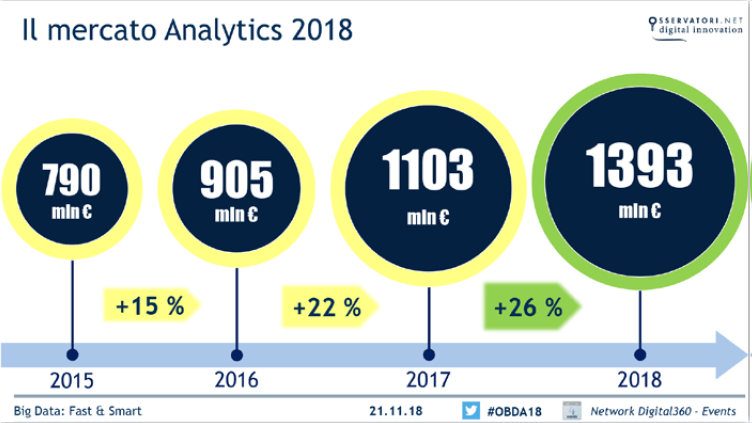

Il mercato italiano dei Big Data Analytics raggiunge quest’anno un valore complessivo di 1,393 miliardi di euro, con una crescita del 26% rispetto al 2017. Un risultato che conferma il trend positivo degli ultimi tre anni, in cui il settore è cresciuto in media del 21% ogni dodici mesi. Le aziende hanno maturato consapevolezza sul tema e l’hanno trasformata in investimenti infrastrutturali, sperimentazioni e progetti in produzione.

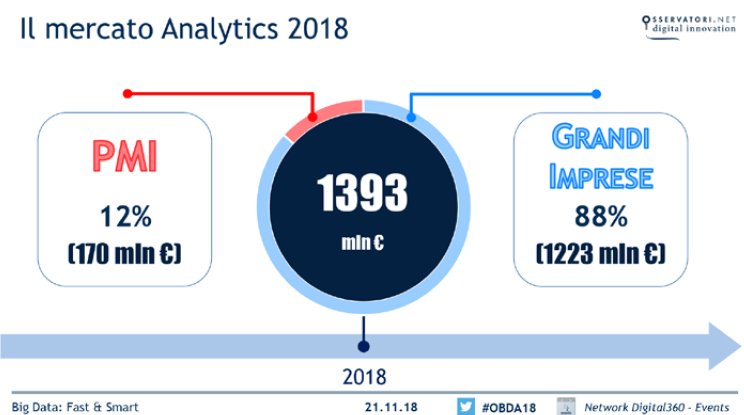

Tuttavia, rimane molto ampio il divario fra le grandi imprese (vero motore della crescita), che si dividono l’88% della spesa complessiva e le PMI, che rappresentano una quota esigua del mercato fermandosi al 12%.

Il processo che porta ad un approccio diffusamente maturo nelle aziende italiane è tutt’altro che compiuto.

Destinatari della spesa, indici di crescita e settori Analytics

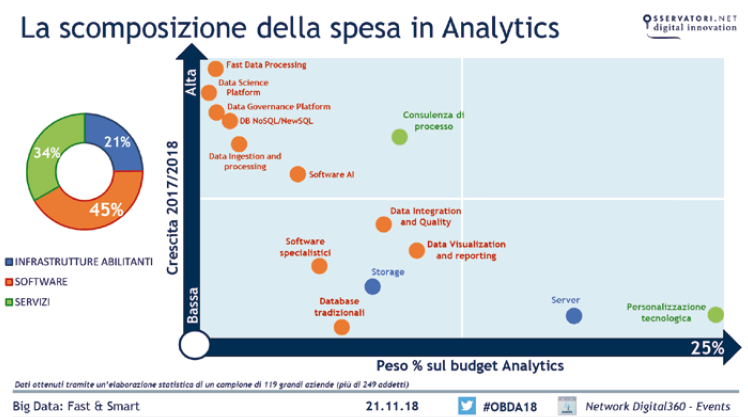

Il 45% della spesa in Analytics è dedicato ai software (database e strumenti per acquisire, elaborare, visualizzare e analizzare i dati, applicativi per specifici processi aziendali), il 34% ai servizi (personalizzazione dei software, integrazione con i sistemi informativi aziendali, consulenza di riprogettazione dei processi) e il 21% alle risorse infrastrutturali (capacità di calcolo, server e storage da impiegare nella creazione di servizi di Analytics).

I software sono anche l’ambito con la crescita più elevata (+37%), seguito dai servizi (+23%) e risorse infrastrutturali (+9%).

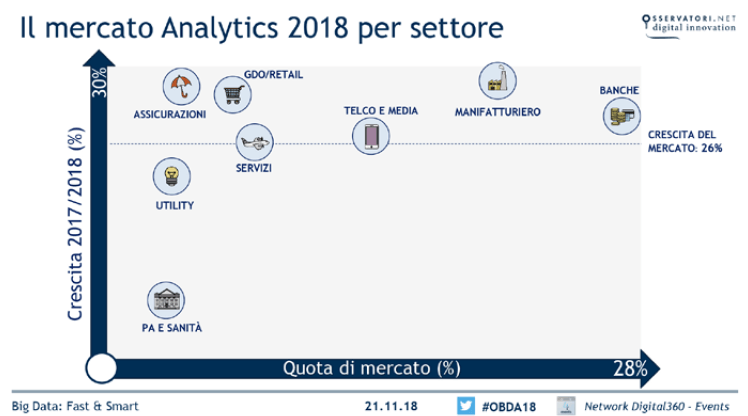

Tra i comparti merceologici, invece, i primi per quota di mercato sono le banche (28% della spesa), manifatturiero (25%) e telco – media (14%), seguiti da servizi (8%), GDO/Retail (7%), assicurazioni (6%), utility (6%) e PA e sanità (6%).

La nuova sfida: soluzioni Fast & Smart

L’infrastruttura evolve e si dota di tecnologie sempre più performanti.

“Il mercato dei Big Data Analytics continua a crescere a ritmi serrati, superiori al 25% – afferma Carlo Vercellis, Responsabile scientifico dell’Osservatorio Big Data Analytics & Business Intelligence – Crescono iniziative “fast data”, in cui l’analisi dei dati avviene in tempo reale, integrando diverse fonti informative in streaming e valorizzando in particolare le potenzialità della Internet of Things: tra queste ricordiamo real-time advertising, fraud detection, predictive maintenance, new product development. Ma per coglierne appieno i benefici, è necessario che i Big Data vengano analizzati secondo modalità smart, mediante sofisticati algoritmi di machine learning in grado di identificare pattern e correlazioni presenti nei dati e di trasformare questa conoscenza in azioni concrete che permettano alle imprese di acquisire vantaggio competitivo”.

Parallelamente sono cresciute le organizzazioni che hanno inserito al proprio interno professionalità qualificate per la gestione degli Analytics, quali Data Scientist, Data Engineer, Data Architect e Data Analyst e che hanno introdotto modelli organizzativi in grado di sfruttare al meglio le opportunità di innovazione e di aumentarne la pervasività, uniformando scelte tecnologiche e dando vita a meccanismi di coordinamento strutturati.

La dimensione aziendale influisce sulla crescita: grandi imprese e PMI a confronto

“Le dinamiche di crescita del mercato sono diverse a seconda delle dimensioni aziendali – afferma Alessandro Piva, Responsabile della ricerca dell’Osservatorio Big Data Analytics & Business Intelligence-: mentre le PMI inseguono a fatica, tra le grandi aziende si è diffusa la convinzione che sia giunto il momento dell’azione: le imprese che hanno già avviato progetti ne stanno raccogliendo i benefici e sono spinte a continuare a investire, quelle rimaste indietro percepiscono l’urgenza di attrezzarsi.”

Le grandi imprese

La totalità delle grandi organizzazioni adotta Analytics di tipo descrittivo, ma molte stanno sperimentando un’evoluzione verso logiche di predictive, prescriptive e, in alcuni casi, automated Analytics.

Il 62% delle grandi aziende dichiara la necessità di competenze specifiche di Machine Learning e Deep Learning: tra queste, poco più di 1/3 le ha già introdotte in organico e un ulteriore 30% prevede di farlo nei prossimi due anni. Poco più di un’azienda su dieci (11%) invece sfrutta oggi modalità di analisi in Real-Time o in Streaming, in cui vi è un flusso continuo di raccolta dei dati che devono essere analizzati con continuità. Un ulteriore 33% possiede un’infrastruttura che consente analisi in Near Real-Time, con una frequenza d’aggiornamento che scende a meno di un’ora. Il 56% delle organizzazioni analizza i dati in modalità batch, con un aggiornamento del sistema a intervalli regolari e predefiniti (solitamente giornalieri).

Le difficoltà maggiori che ostacolano il percorso di adozione di progetti Analytics riguardano la mancanza di competenze e figure organizzative interne (53%), l’integrazione dei dati (45%) e la stima dei benefici dell’investimento (34%). Seguono la mancanza di coinvolgimento del management (27%), la necessità di investimenti troppo elevati (22%), la difficoltà nel reperire dall’esterno professionalità con competenze adeguate (18%), la scarsa qualità e affidabilità dei dati (18%) e le difficoltà nell’impiego di software e altre tecnologie (14%).

Tra le aree più supportate in cui si possono applicare gli Analytics, vi sono customer care, ottimizzazione delle scorte, cross/up-selling, ottimizzazione degli acquisti, valutazione del rischio di credito, monitoraggio della reputazione del brand, predizione del tasso di churn, tracciamento degli asset all’interno o all’esterno dell’azienda e manutenzione predittiva.

Le PMI

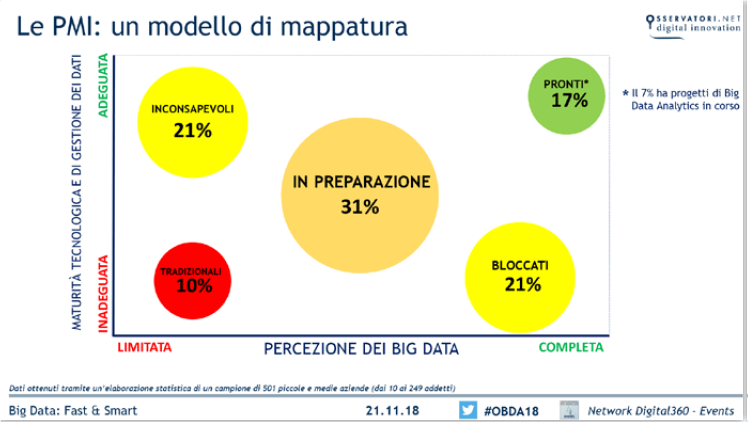

Soltanto il 7% delle PMI nel 2018 ha avviato progetti di Big Data Analytics, mentre 4/10 dichiarano di svolgere analisi tradizionali sui dati aziendali. Se si guarda alla consapevolezza e alla maturità tecnologica delle piccole e medie imprese, dalla ricerca emerge come il 10% continuano ad avere una comprensione scarsa o nulla di quali vantaggi i Big Data potrebbero apportare e di come hanno un approccio all’analisi dei dati limitato e tradizionale. Poco meno di un terzo delle aziende, il 31%, è invece sulla buona strada sia dal lato della consapevolezza sia dal lato tecnologico. Circa quattro aziende su dieci (42%), inoltre, si sono mosse in una soltanto delle due direzioni o a causa di una visione limitata del fenomeno o a causa della mancanza di risorse per effettuare investimenti tecnologici. Una PMI su dieci, infine, si dimostra pronta per lanciare delle iniziative di Analytics.

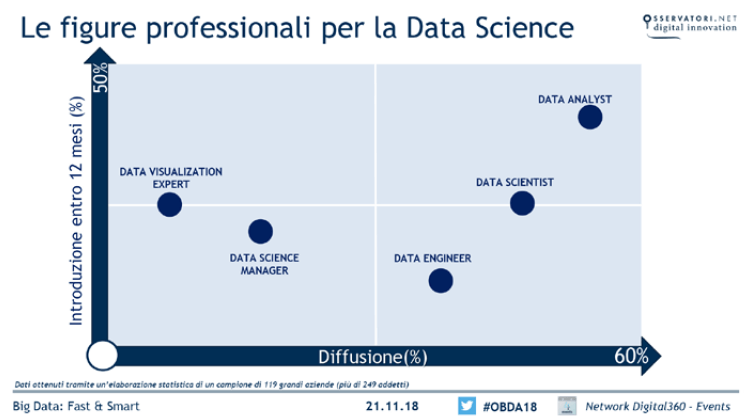

Le figure professionali dedicate alla Data Science: non solo Data Scientist

Nel 2018 si registra un importante aumento (dal 17% al 31%) delle grandi organizzazioni che si sono dotate di un modello di governance per la Data Science maturo e che hanno inserito figure di Analytics in diverse funzioni aziendali, favorendone il coordinamento e la crescita. Oltre metà del campione (55%), però, si trova ancora in una situazione tradizionale, dove non esiste alcuna spinta verso una strategia basata sull’analisi dei dati, mentre il 14% delle grandi aziende italiane si trova all’inizio del percorso di costruzione di una strategia data driven.

La mancanza di competenze interne rimane il principale elemento di freno allo sviluppo di progetti di Big Data Analytics. Il 77% delle grandi aziende segnala una carenza di risorse interne dedicate alla Data Science: fra queste, il 29% ritiene di poter sopperire a queste lacune con il supporto di consulenti esterni, mentre il 48% considera necessaria l’internalizzazione delle competenze di Analytics nel breve termine.

Nel processo di internalizzazione di queste competenze, oltre al disequilibrio tra domanda e offerta, le aziende si scontrano con la ricerca di ruoli poco standardizzati, dei quali non si conoscono le principali competenze. Per questo motivo, la Ricerca ha approfondito il tema delle figure professionali dedicate agli Analytics non soltanto attraverso i dati di diffusione, ma anche attraverso l’analisi di tutte le offerte di lavoro rilevanti presenti su LinkedIn, al fine di ottenere informazioni più qualitative sulle principali competenze e attività svolte.

Il Data Scientist è una figura professionale ormai diffusa nelle aziende. Il 46% delle grandi imprese ha inserito uno di questi profili e tra chi non lo ha ancora in organico, 1/4 prevede di introdurlo entro il 2019. Tra le aziende maggiormente strutturate (più di 1.000 addetti), il 28% ha definito formalmente questo ruolo, il doppio rispetto a quanto si registra tra le aziende dai 250 ai 1000 dipendenti. Dall’analisi condotta dall’Osservatorio su tutte le offerte di lavoro presenti su LinkedIn, emerge che i requisiti più ricercati sono la capacità di utilizzare almeno un linguaggio di programmazione (nel 74% delle offerte), le competenze di sviluppo e implementazione di algoritmi di machine learning (62%), l’abilità di comunicare e presentare i risultati agli utenti di business (36%). Dalla rilevazione diretta alle grandi imprese: le competenze di Machine Learning e Deep Learning sono ad oggi presenti in una grande azienda su cinque.

Il Data Engineer è responsabile di una serie di attività preliminari vincolate poi all’estrazione e la consegna degli insight che consistono nella progettazione dell’infrastruttura e nella costruzione e manutenzione dei “tubi” attraverso i quali i dati arrivano agli strumenti di front-end. Un ruolo di assoluta rilevanza, inserito nel 42% delle grandi imprese, con una presenza formalizzata nel 17% dei casi, mentre il 13% prevede di assumere almeno uno di questi profili nel 2019. Secondo l’analisi delle offerte su LinkedIn, tra le mansioni svolte da questi professionisti, figurano la gestione della data ingestion (32%) e la creazione di data pipeline (24%). Nel 58% dei casi si richiede la capacità di programmazione in Python e Javascript. Secondo quanto emerge dall’analisi di LinkedIn, risulta essenziale la capacità di utilizzare Hadoop (domandata dal 65% delle offerte) e sistemi di database management (relazionali o NoSQL).

Il Data Analyst si occupa di ricercare evidenze quantitative all’interno di grandi moli di dati, supportando in tal mondo le decisioni di business. Nonostante l’attività di analisi dei dati sia centrale sia per il Data Analyst che per il

Data Scientist, queste due figure si differenziano per grado di profondità d’analisi e strumenti utilizzati. È presente nel 56% delle grandi aziende italiane ed entro il 2019 si prevede che la percentuale raggiungerà il 75%.

Dalle informazioni di LinkedIn, le sue principali attività sono la produzione di reportistica efficace (nel 56% delle offerte) e l’individuazione di pattern e relazioni tra grandi moli di dati (28%), mentre i principali strumenti utilizzati sono Excel e MySQL.

Altre figure rilevanti

Ci sono altre due figure professionali relative al mondo della Data Science: il Data Science Manager e il Data Visualization Expert.

Il Data Science Manager è una figura di coordinamento della struttura di Analytics, che si pone a gestione di una specifica struttura di Analytics o di tutte le persone che si occupano di Analytics in azienda, a seconda della configurazione organizzativa. È presente nel 23% delle grandi aziende, mentre ne è prevista l’introduzione entro dodici mesi nel 22% dei casi.

Il Data Visualization Expert è invece un ruolo emergente, che sicuramente riceverà maggior attenzione nei prossimi anni. Si tratta di una figura all’intersezione tra competenze di Analytics e di dashboard design, si occupa di trovare la migliore rappresentazione grafica per differenti tipologie di dati e di analisi, in modo da facilitare la comunicazione con le figure di business. Al momento e presente in circa una grande azienda su dieci (9%), ma una su quattro prevede di introdurlo entro il 2019.

Big Data Analytics e GDPR

Alla luce del General Data Protection Regulation, il Regolamento europeo nato con l’obiettivo di definire un nuovo quadro comune in materia di tutela dei dati personali e favorirne la circolazione sicura nel perimetro comunitario, sorgono punti di criticità in relazione ai Big Data Analytics.

- Perdita di controllo dei dati e mancanza di limiti temporali per la conservazione dei dati: il concetto di data lake si accompagna all’idea di raccogliere quanti più dati possibili, preoccupandosi solo in un secondo momento di come utilizzarli. Inoltre, l’efficacia di un progetto di Big Data Analytics può essere ridotta se si pongono limiti temporali alla conservazione dei dati;

- Informative inadeguate ai soggetti interessati: se le aziende svolgono operazioni quantitativamente e qualitativamente diverse sui dati, le informative devono essere adeguate ai tempi, di modo che siano davvero in grado di informare gli interessati su tutte le finalità per le quali i dati vengono raccolti. Finalità che non è sempre possibile conoscere ex-ante in un contesto Big Data;

- Riduzione della possibilità di rimanere anonimi: la correlazione tra diverse fonti dati, seppur di natura non personale, può facilitare un processo di de-anonimizzazione delle informazioni. Tuttavia, è proprio la correlazione tra diverse fonti dati ad essere uno dei principali punti di forza di un progetto Big Data.

Il GDPR ha avuto un impatto sulle iniziative di Big Data Analytics in termini di azioni intraprese dalle aziende e di implicazioni sui progetti, con azioni sulle policy interne, sia di accesso ai dati (62%) sia di conservazione (55%). Il 43% delle grandi aziende ha inserito delle voci relative agli Analytics nelle nuove informative sulla privacy rivolte ai clienti, mentre il 24% ha investito in tecnologie specifiche.

Meno di una grande azienda su tre (30%) dichiara che l’avvento del GDPR ha rallentato i progetti di Analytics in corso e soltanto l’1% ha dovuto bloccare delle iniziative a causa della nuova normativa. Per circa un’azienda su cinque (il 22%) il GDPR ha avuto un impatto positivo, soprattutto perché ha aumentato la consapevolezza sulle potenzialità degli Analytics (17%) e poi perché la presenza di un chiaro quadro normativo ha permesso di pianificare nuove iniziative nel medio-lungo periodo (5%). Per il 38% delle grandi aziende il GDPR non ha avuto nessuna conseguenza in ambito analisi dati: un segnale positivo, perché indica che queste aziende erano già preparate per adattarsi al cambiamento normativo. Infine, il 9% delle grandi organizzazioni non sa come valutare l’impatto del fenomeno.

La ricerca dell’Osservatorio ha inoltre evidenziato che le organizzazioni con una struttura dedicata alla Data Governance si sono dimostrate più preparate ad affrontare il tema: tre aziende su quattro hanno modificato le proprie informative sulla privacy con voci relative agli Analytics e più della metà delle aziende ha acquistato soluzioni tecnologiche specifiche.

Le startup

L’Osservatorio ha censito 443 startup operanti nel mercato dei Big Data Analytics, fondate a partire dal 2013 e finanziate dal 2016 in avanti, per un totale di 4,74 miliardi di dollari di investimenti raccolti (12 milioni in Italia). Quelle che complessivamente raccolgono più finanziamenti, circa 30,6 milioni di dollari ciascuna, sono in ambito Technology (l’8% del totale delle startup) e offrono strumenti per la raccolta, l’analisi, l’immagazzinamento, l’organizzazione e integrazione dei dati. Seguono le startup in ambito Analytics System (il 29% del totale, per circa 12,8 milioni di finanziamenti ciascuna), soprattutto di soluzioni che consentono di estrarre rapidamente informazioni da un database e di effettuare analisi predittive, piattaforme per l’analisi di video e immagini, strumenti per visualizzare efficacemente i dati e piattaforme per analisi testuali. Chiude la categoria più numerosa, Application (63% delle startup, per 10,3 milioni di investimenti ciascuna), che comprende le imprese innovative che hanno sviluppato un’offerta specializzata per un particolare settore o per una funzione aziendale, fra cui soluzioni di sicurezza informatica, marketing intelligence e strumenti per il miglioramento dei processi HR.