Reti supporta Generalfinance nella gestione della piattaforma digitale EFintecH. Il focus è sull’infrastruttura database, un servizio in grado di assicurare la trasformazione data driven in vista dell’adozione di Predictive analytics e Machine learning.

Grazie a “una visione olistica sulla gestione dei dati a 360 gradi“, commenta Reti, l’obiettivo di Generalfinance è migliorare il processo decisionale, tramite data analytics, Machine learning, AI applicate al business. Ecco come.

Il modello Data driven di Reti per Generalfinance

Reti ha sviluppato per Generalfinance un servizio che permette di mantenere un’alta efficienza dei sistemi database e Business intelligence (BI). L’obiettivo consiste nell’assicurare il pronto ripristino delle attività aziendali in caso di criticità legate ai database. Allo stesso tempo, punta a ridurre i costi di mantenimento e a migliorare la gestione dei dati.

“In riferimento al piano di Digital transformation di Generalfinance per il periodo 2019-2022”, spiega Reti, “uno dei pillar fulcro è stato definito nella realizzazione di un’architettura Data driven con i paradigmi della Digital innovation che permettesse di migrare la vecchia architettura di BI e dei suoi processi utilizzando le più recenti versioni di SQL Server (2019), opportunamente configurate, per interagire sotto la tecnologia dell’always on con diversi availability group disposti in più nodi”.

Questa soluzione ha permesso “una maggiore affidabilità e continuità dei servizi. Grazie alla possibilità di garantire la disponibilità dei dati in modo continuo”, continua Reti, “attuando il failover automatico dell’AG tra i nodi predisposti”.

La migrazione

Generalfinance ha adottato il modello data driven “a fine 2022, oltre ad aver migrato l’architettura old, innovandola”, sottolinea Reti. Infatti, “l’azienda ha completato il modello di Data driven, nell’ambito del progetto da noi impostato e sta migrando da una pregressa gestione su file system a una gestione centralizzata su un’istanza esclusiva per gli Integration Services di SQL Server“.

Il progetto punta a ridurre i costi di mantenimento dell’infrastruttura database, aumentando la qualità dei servizi offerti agli utenti interni.

“Questa scelta ha permesso di migliorare il controllo, la gestione, il deploy, la sicurezza e le performance dell’intero sistema”. Ma consente anche di “avere una visione globale dell’intero flusso di lavoro di BI”.

“Tra le nuove feature utilizzate spicca il Filestream per la gestione e l’archiviazione di file di particolari processi di business”, evidenzia Reti.

I dettagli tecnici

“Il Filestream è un’opzione di SQL Server che consente di gestire file di grandi dimensioni in modo efficiente e di archiviarli in modo affidabile all’interno del database, senza compromettere le prestazioni del sistema”, spiega Reti.

“Abbiamo utilizzato questa funzionalità per la gestione di file legati a processi di business specifici”, continua Reti: “Come ad esempio documenti o immagini associati a un cliente o a un ordine”.

Vediamo le principali caratteristiche di questo progetto e le tecnologie di cui si avvale. “Per garantire una corretta gestione del sistema database e per monitorare le performance”, entra nei dettagli Reti, “abbiamo implementato diverse procedure sia native, sia di raccolta di metriche utilizzando microservizi sul docker“.

“Alcuni degli applicativi utilizzati che spiccano in quest’area sono: Grafana, Prometheus, Loki, oltre a vari exporter sviluppati ad hoc per SQL Server. Questa soluzione ha permesso di avere una visione completa delle attività svolte dai singoli nodi e di rilevare eventuali criticità in tempo reale da un punto di vista molto ravvicinato sui servizi SQL”.

Privacy e Data governance

“Sul lato privacy e Data governance”, continua Reti, l’azienda ha implementato “soluzioni per l’auditing e il logging delle attività sui dati. In particolare, sono stati configurati meccanismi di auditing per monitorare le operazioni di accesso e modifica ai dati, in modo da avere tracciabilità e controllo su tutte le azioni svolte dagli utenti autorizzati“.

Inoltre, l’implementazione ha posto “una grande attenzione ai role permission”. Al fine di “garantire e limitare gli accessi differenziando i dati in base al ruolo dell’utente e alle sue responsabilità”, sottolinea Reti.

Controllo sulla Data management

“In questo modo, è stato possibile garantire un controllo adeguato sulla gestione dei dati, prevenendo eventuali violazioni o accessi non autorizzati”.

“Altri progetti sono in fase di studio e sviluppo”. Lo scopo è quello di “portare una visione globale sulla gestione del dato grazie anche a nuovi prodotti innovativi sul mercato, quali Azure Purview, che offre funzionalità avanzate per il Data governance, quali:

- catalogazione dei dati;

- profilazione;

- mappatura delle relazioni;

- definizione delle politiche di sicurezza”.

L’azienda, inoltre, “potrà sviluppare una visione olistica sulla gestione dei dati a 360 gradi”. Potrà così adottare anche “un approccio più strategico e integrato che tiene conto non soltanto delle esigenze di sicurezza e conformità, ma anche delle esigenze di business“, evidenzia Reti.

Disaster recovery e cybersecurity per Generalfinance

Grazie a Reti, Generalfinance scommette sulla sicurezza informatica. Si tratta della sicurezza dei punti di ingresso per potenziare la Business continuity. Ma prevede anche attività continue di risk assessment. L’obiettivo è proteggere la piattaforma digitale proprietaria da eventuali cyber incidenti.

“Il team di Generalfinance ha principalmente eseguito queste tematiche e implementazioni, utilizzando Crowdstrike e Cloudflare (tra gli altri)”, spiega Reti.

“Lo spettro d’azione dell’engagement di Reti riguarda nello specifico la tematica verticale dei database e della loro messa in sicurezza, con particolare attenzione alla security, applicando patch, hotfix e cumulative update (CU) in tutte le istanze. È stato anche effettuato un ‘security scan’ di tutte le istanze per analizzare i report emersi con processi/routine dedicate al mondo SQL”.

“La sicurezza è sempre molto legata alla Data governance, concetti e soluzioni in continua evoluzione e ammodernamento”, sottolinea Reti. L’azienda “ha apportato migliorie sostanziali intercettando le macro-lacune che lasciavano aperte vulnerabilità potenzialmente dannose e ruoli con permessi al di sopra dello spettro di competenza“.

Obiettivi prioritari sono, infatti, anche una migliore gestione dei dati e un potenziamento della sicurezza dei punti di ingresso della rete. Attraverso modalità di certificazione dedicate, nell’obiettivo di rafforzare la Business continuity.

L’ecosistema infrastrutturale a presidio del Disaster recovery e della cybersecurity ha previsto un “progetto di miglioramento dell’architettura di SQL Server” che “si è concentrato su tre fronti principali: esterno, trasversale e interno di ogni istanza”.

Protezione del perimetro esterno

Reti ha innanzitutto protetto il perimetro esterno, “al fine di garantire un’installazione corretta e sicura di SQL Server”.

“Ciò ha comportato l’implementazione di patch, hotfix e CU per garantire l’aggiornamento costante e la sicurezza del software (anche al livello di Windows). È stata, inoltre, eseguita una separazione di rete adeguata a dividere fisicamente gli ambienti (Dev, UAT, Quality e PROD)”.

Reti ha anche svolto “una attenta e scrupolosa valutazione delle licenze, proporzionandola all’utilizzo effettivo del software per i reparti, a seguito di un’analisi delle metriche in nostro possesso”.

Il fronte trasversale

Il versante trasversale “ha riguardato la configurazione dei servizi, la gestione della rete e la messa in atto di azioni di auditing e logging”, mette in evidenza Reti che, inoltre, ha implemento “una soluzione di file sharing efficace per agevolare la condivisione dei dati tra i vari utenti e/o i servizi”.

Il fronte interno

Infine, sul fronte interno, Reti spiega di aver eseguito “ottimizzazioni sui singoli database”. Ha migliorato “il loro design, la separazione dei dati, gli indici, la compressione delle pagine e la corretta configurazione di ruoli e permessi”. Complessivamente, “l’implementazione di queste azioni ha permesso di garantire un’installazione sicura e corretta di SQL Server in linea con le aspettative di Generalfinance”, conclude Reti.

Data analytics secondo i tre pillar

Lo sviluppo del progetto di Reti è il fiore all’occhiello degli investimenti di Generalfinance. L’azienda è impegnata a rafforzare la piattaforma informatica proprietaria in ottica di una strategia Data driven. Lo scopo è migliorare il processo decisionale sulla base dei dati proprietari.

“La costruzione del Data analytics in Generalfinance”, spiega l’azienda, ha determinato “che l’utilizzo dei dati in tutte le sue dimensioni – in tempo reale, storici, non strutturati, strutturati, qualitativi” deve diventare punto di partenza. “L’origine per individuare i modelli e generare idee per ‘informare’ e, in alcuni casi, automatizzare il processo decisionale”.

Una tale costruzione “porta, nell’ambito del processo decisionale e operativo del factoring, a digitalizzare l’aspetto di azione supportato dall’intelligenza artificiale“, afferma Generalfinance.

“Grazie all’infrastruttura Sql Server configurata nelle sue caratteristiche di massima evoluzione, non solo svolta con l’apporto fondamentale di Reti da un punto di vista sistemistico, siamo riusciti a implementare la Data analytics secondo i tre pillar base: Data wrangling, Data visualization e Location analytics”, sottolinea Generalfinance.

Data wrangling, Data visualization e Location analytics

“Il Data wrangling“, illustra Generalfinance, “è il processo che prevede la raccolta di dati provenienti da diverse fonti, e li ‘pulisce‘ per un semplice accesso e una facile analisi”.

“La Data visualization è la rappresentazione grafica dei dati per aiutare le persone a comprenderne il contesto e il significato”, continua la società.

Infine “la Location analytics è la pratica di aggiungere un livello di dati geografici alle risorse dei dati”. Al fine di “estrarre informazioni più preziose”.

Obiettivo: Predictive analytics e Machine learning

“L’architettura così costruita ha la ‘vision’ per poter implementare entro il prossimo biennio due modelli di intelligenza a supporto del processo del credito fulcro del Factoring: la Predictive analytics e il Machine learning“.

“La Predictive analytics“, infatti, “è il metodo di utilizzare i dati per modellare le previsioni sulla probabilità di potenziali risultati futuri”. Invece “il Machine learning comporta l’automazione di modelli analitici utilizzando algoritmi che imparano iterativamente dai dati e ottimizzano le prestazioni”, conclude Generalfinance.

Dati di mercato

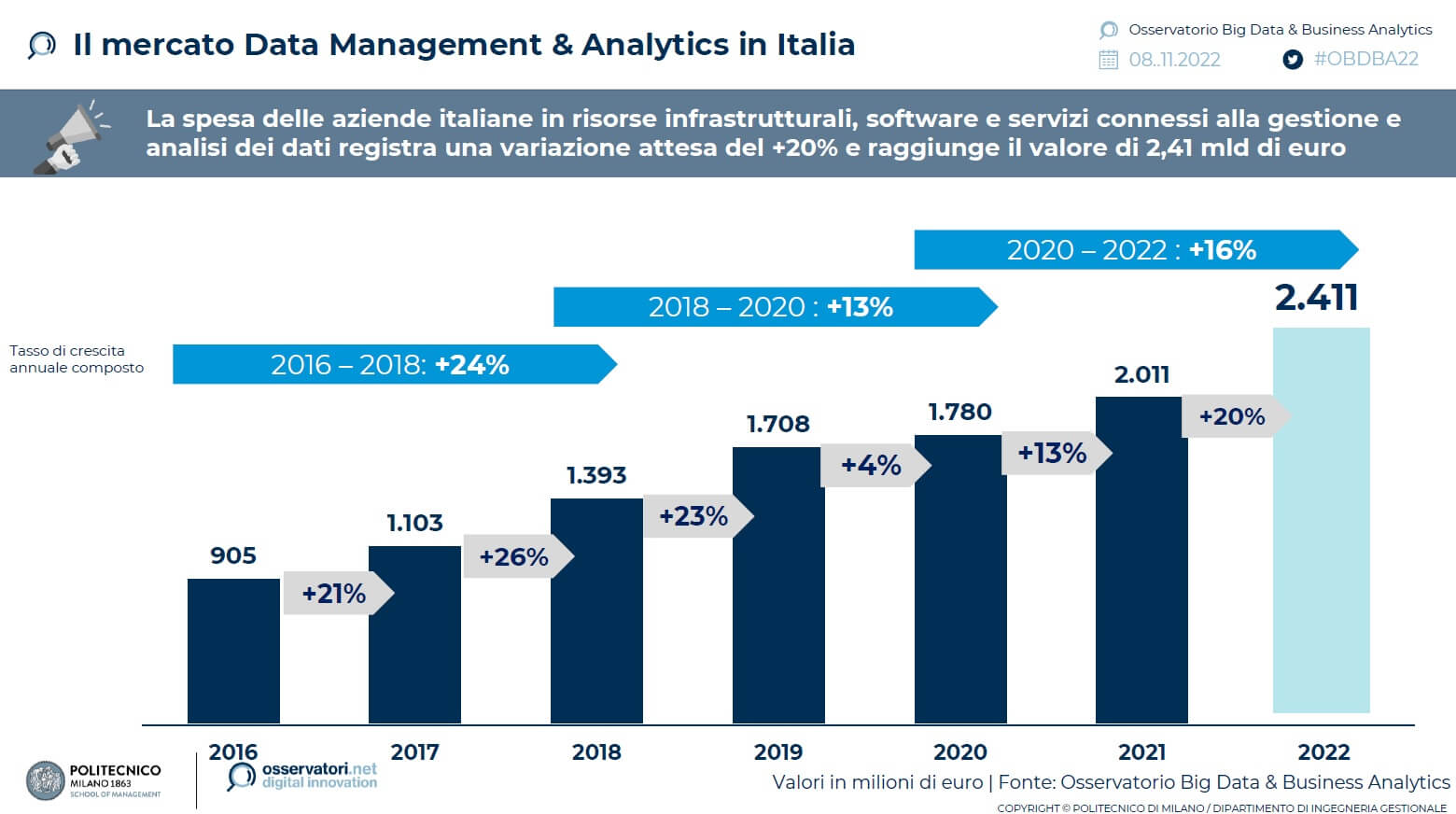

Secondo l’Osservatorio Big Data & Business Analytics della School of Management del Politecnico di Milano, nel 2022 le aziende con una Data strategy di livello corporate sono ancora minoranza. Ma il mercato tricolore dei Big data è in crescita del 20% e vale 2,41 miliardi di euro.

Nell’ambito della Business intelligence e Descriptive analytics, inoltre, il 69% sfrutta strumenti di Data visualization avanzati. Il 65% (contro il 54% dell’anno prima) ha avviato almeno una fase sperimentale con gli Advanced analytics. La consapevolezza sta aumentando.

Conclusioni

Il lavoro che Reti sta svolgendo in sinergia con Generalfinance “si colloca all’interno di una visione di crescita consapevole e sostenibile”.

Questo modello “porterà molti vantaggi nel lavoro quotidiano delle persone”. Si tratta di “un affiancamento lungo un tratto di percorso che auspico sia l’inizio di un viaggio insieme”, sottolinea Bruno Paneghini, Presidente e AD di Reti S.p.A.

La piattaforma digitale che Generalfinance ha realizzato negli anni evolverà ancora nel futuro. “Per migliorare le performance del business, supportando anche, grazie a questo importante progetto, una strategia Data driven“, afferma Stefano Biondini, Chief Operating Officer di Generalfinance: “Vale a dire assumere decisioni oggettive in base ai dati proprietari”.

“Il dato, nel contesto attuale di digitalizzazione, ha valenza non solo per la sua fruibilità di processo funzionale e operativo, ma anche e soprattutto per finalità decisionale attraverso soluzioni di data analytics, machine learning, AI applicate al business. Il tutto deve poi essere supportato da un ecosistema infrastrutturale a presidio del Disaster recovery e della cybersecurity”, conclude Biondini.