Sapere scegliere è la più preziosa e spesso più sottovalutata dote di ogni professionista. Così come un manager deve sapere scegliere i propri collaboratori, questi devono sapere scegliere gli strumenti di lavoro migliori, peraltro senza potersi permettere il lusso di impiegare troppo tempo, perché i flussi aziendali sono un polmone che ha i propri ritmi. I Data analytics tool non sono tutti uguali, si prestano per esempio meglio per alcuni ambienti a discapito di altri, o sono più votati all’elaborazione di algoritmi piuttosto che alla visualizzazione dei dati.

È utile, prima di iniziare, fornire una definizione condivisibile di Data analytics tool.

Cosa sono gli strumenti Data analytics tool

Sono software e applicazioni che aiutano i Data scientist a creare e usare processi di analisi al fine di fornire ai vertici dell’azienda gli strumenti utili per prendere decisioni ragionate, realistiche e adeguate al momento contingente. Tutto ciò riducendo i costi e impattando positivamente sui profitti.

Per quanto una definizione possa essere esaustiva, non sarà mai sufficiente a descrivere appieno l’ampiezza del contesto in cui si situa. L’analisi dei dati, peraltro, è difficilmente ascrivibile a una disciplina definita e ciò non deve stupire perché altrettanto accade in altri ambienti: per fare un esempio, la matematica è una, ma quella usata dai fisici è diversa da quella in uso ai teorici della biologia. Le regole non cambiano, al contrario delle declinazioni e della specificità.

Come scegliere un Data analytics tool

Quando si parla di una qualsiasi disciplina che riguarda i dati, sono proprio questi ultimi a dettare le regole. Occorre prima di tutto considerare il tipo di dati da analizzare, perché alcuni tool spiccano per alcune prerogative rispetto ad altre: qual è la mole di dati da analizzare? quali sono i formati dei dati? con quali tecnologie sono archiviati (locali, remote, in Cloud, su database proprietari o Open source)? quali sono i linguaggi di programmazione diffusi nell’azienda?

Trovata la risposta a queste e altre domande, occorre chiarire quali sono gli obiettivi da raggiungere, quali eventuali necessità ci sono di automazione di processo o di visualizzazione dei dati stessi, oltre ovviamente al tipo di analisi e alla sua profondità.

I benefici della Data analysis

L’obiettivo ultimo di estrarre valore dei dati è un concetto ampio. Sono molti gli scenari, a partire dalla necessità di ottenere dai dati delle informazioni invisibili all’occhio umano come, per esempio, un repentino cambio di abitudini del mercato di riferimento o il nascere di una nuova necessità che i clienti stanno palesando un po’ alla volta.

Allo stesso modo l’analisi dei dati può essere usata per gestire e fare rientrare situazioni di emergenza laddove, per esempio, un errore di fabbricazione di un prodotto sta generando il malcontento tra i clienti che lasciano pessime recensioni online, approfittando anche della capillarità dei social media.

Ogni comparto aziendale può essere supportato e persino guidato dall’analisi dei dati, che permette di scovare aree nelle quali è possibile migliorare e, nella sua misura predittiva, consente anche di anticipare problemi o criticità che possono subentrare, viziate per esempio da situazioni di mercato inattese, come una scarsità delle materie prime o dei problemi logistici dovuti a eventi esterni e avversi, basti pensare a uno sciopero dei trasportatori o a una repentina esplosione del costo dei carburanti. La capacità di analisi predittiva permette di simulare diversi scenari e stilare procedure a cui ispirarsi nei momenti di difficoltà.

Data analytics tool, le nostre 10 prove

Ci sono strumenti che sono sulla bocca di tutti, pensiamo soprattutto a MySQL Workbench o Apache Spark dei quali abbiamo già parlato qui. Si sta diffondendo anche l’idea – peraltro non del tutto infondata – che Microsoft Excel possa essere uno strumento di Data analysis perché ci sono sempre più strumenti built-in che possono essere utilizzati da chiunque senza conoscenze particolari.

Si tratta di una verità parziale perché Excel soddisfa le esigenze di analisi poco approfondite tipiche di piccolissime realtà aziendali. Per analisi più complesse occorrono strumenti più evoluti di quelli che i fogli di calcolo di Microsoft possano offrire.

Qui proponiamo altre soluzioni in grado di interagire con basi di dati di enormi dimensioni, alcune meno blasonate di altre, ma non per questo non degne di nota.

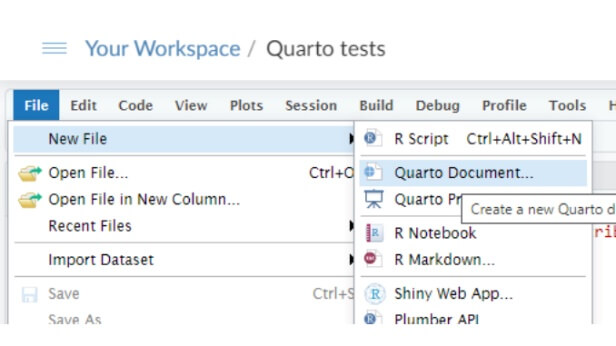

Posit RStudio

Ha una storia ultradecennale ed è tra i migliori Data analytics tool per R e Python. Nato nel 2009 con il nome di RStudio, questo tool offre circa 10mila tra packages ed estensioni per l’analisi statistica e il data modeling (modellazione dei dati in italiano), ovvero il processo utile a definire quali requisiti devono avere i dati per offrire un valido supporto ai processi aziendali. Nel concetto di data modeling, assai ampio, rientrano anche la naming convention dei dati, la semantica, la qualità e la sicurezza.

Anche gli amministratori di database fanno ricorso al data modeling per definire le relazioni tra le tabelle, individuare le primary key o le stored procedure in fase di progettazione di una base di dati.

Alcune librerie (su tutte plotly e ggplot) consentono anche la visualizzazione grafica e questo fa di Posit uno strumento ampiamente ricorrente tra gli attori della Data science.

Esiste in diverse versioni e può essere installato on-premise con client compatibili con Windows, macOS e Linux oppure può essere usufruito in Cloud, acquistando quindi anche la potenza di calcolo necessaria.

Poiché molto diffuso – ne fanno uso anche i giganti del web come Alphabet, Meta e Twitter – conta su una comunità nutrita che si impegna a distribuire conoscenza.

I costi per la versione client-server partono da 995 dollari l’anno (925 euro al cambio attuale) mentre, per le versioni Cloud, la politica di pricing è diversa. Lo si può ottenere gratuitamente con limiti d’uso oppure a partire da 99 dollari al mese (92 euro) per l’uso aziendale.

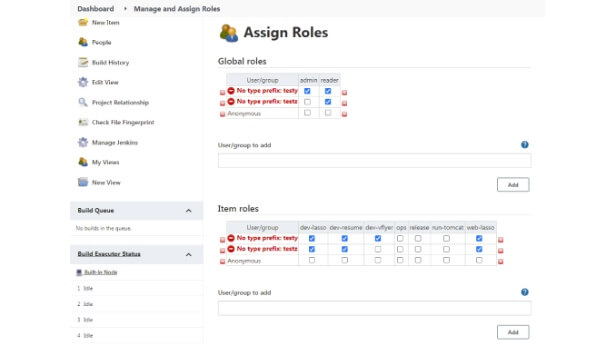

Jenkins

È prima di tutto un tool per l’automazione. Jenkins può essere utilizzato per la Data analytics laddove è necessario eseguire algoritmi e software con una certa periodicità, ogni giorno e a qualsiasi orario.

Gratuito, si integra alle più diffuse piattaforme Cloud che offrono anche servizi per l’analisi dei dati come, per esempio, Amazon Web Services, Google Cloud, IBM Cloud, Microsoft Azure e Oracle Cloud Infrastructure.

Richiede Java e offre una moltitudine di plugin per qualsiasi necessità, financo per l’analisi di dati su Github e per l’integrazione con software database proprietari, come Microsoft SQL.

Jenkins permette anche di pianificare flussi sequenziali uno all’altro, per esempio lavori di estrazione, di pulizia e di elaborazione dei dati che vanno svolti in un ordine stabilito. Si adegua anche alle procedure più complesse e lunghe in termine di tempo, sgravando così i dipendenti da compiti ripetitivi e noiosi.

Anche Jenkins fa leva su una nutrita community multicanale (raggiungibile persino via IRC e Slack) che aiuta chi ne fa uso.

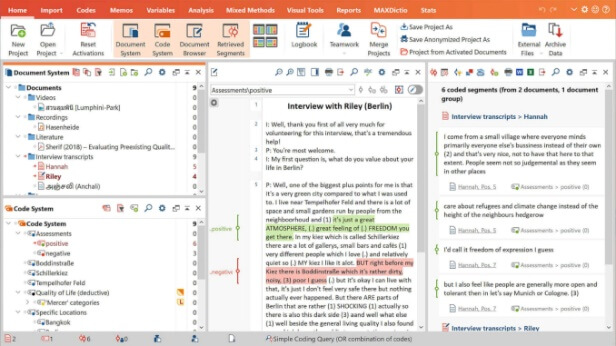

Maxqda

Non ci sono soltanto numeri. I dati che servono alle aziende possono provenire da molte fonti, tra queste i feedback dei clienti (magari scritti sui canali sociali) e, più in generale, informazioni testuali. Qui subentra la necessità del controllo qualitativo dei dati, materia demandata al Deep learning.

Maxqda è un software di analisi qualitativa dei dati che offre la possibilità di apporre contrassegni alle informazioni più importanti, usando codici, simboli o colori. Il supporto Unicode – che assegna un codice univoco a ogni carattere alfanumerico – rende Maxqda utilizzabile con testo scritto in qualsiasi idioma.

Disponibile per Windows e macOS, importa dati da qualsiasi risorsa web e in qualsiasi formato questi siano.

I prezzi si adeguano al mercato di riferimento. Può costare poche decine di euro al mese per gli studenti, le organizzazioni accademiche e quelle no-profit, fino ad arrivare anche a diverse migliaia di euro per le licenze aziendali. Prima di procedere all’acquisto si può provare gratuitamente per 14 giorni.

Datapine

Uno degli aspetti che raramente si portano alla luce e che è uno dei vantaggi dell’analisi dei dati intesa come multi-disciplina che è crocevia di diversi saperi, è la possibilità di essere usufruibile grazie ad automatismi e semplificazioni a vantaggio di chi, pure avendo chiari in mente gli obiettivi delle analisi che intende fare, difetta in conoscenze di programmazione.

Datapine è una delle risposte a questo lack di competenze, perché consente di interagire con query e database mediante drag and drop, facilitando operazioni mediamente complesse che possono essere svolte anche in assenza di spiccate conoscenze di programmazione. Non va sottovalutato questo aspetto, perché può essere di vitale importanza per chi è agli inizi e può essere prezioso – se non altro per il risparmio di tempo che permette di conseguire – anche per i Data scientist più navigati.

Datapine dispone di oltre 80 dashboard da utilizzare e modificare per connettersi a database istallati localmente nell’azienda o in Cloud ma anche alle reti sociali e agli strumenti di web analytics come quelli di Google. Riuscire a svolgere analisi con una manciata di click in un ambiente no-code è una forma di democratizzazione della Data analytics che porta la Business intelligence ovunque.

I prezzi sono comunicati a chi ne fa richiesta ma è possibile usare la versione di prova per 14 giorni.

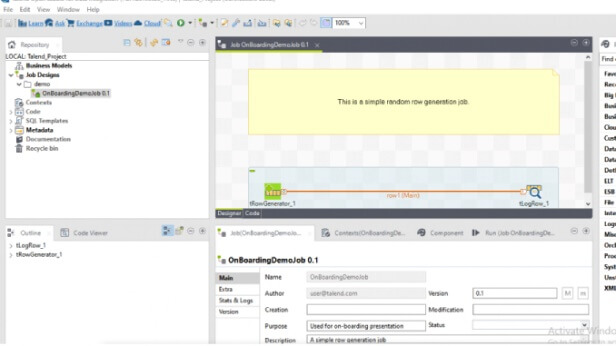

Talend Data Fabric

Quella proposta da Talend è una soluzione scalabile che si adatta tanto alle piccole quanto alle grandi realtà e, al di là di ogni altra considerazione, ha il merito di fornire una suite di strumenti che include l’unificazione dei dati, le operazioni di pulizia e la governance dei dati.

Una soluzione orientata a quello che in gergo viene definito ETL, ossia Extract-Transform-Load dei dati in un sistema.

A questo si aggiunge un’ampia disponibilità di Api che consente l’integrazione con qualsiasi altro applicativo in uso all’azienda e la distribuzione di dati specifici a risorse esterne (clienti, fornitori, entità governative, eccetera).

I prezzi sono comunicati a chi ne fa richiesta, è possibile organizzare una demo.

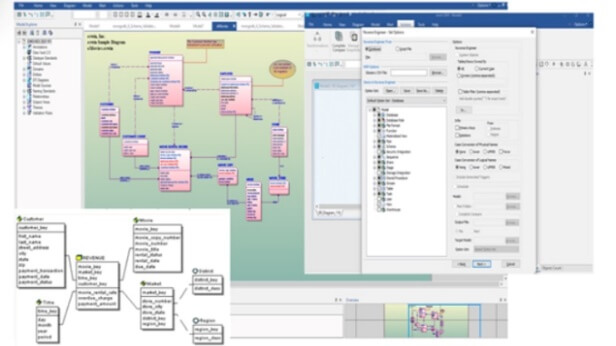

Erwin DM

Torniamo per un momento alla data modeling, questa volta introducendo l’automatizzazione dei processi di generazione di modelli, partendo da dati strutturati o non strutturati. Queste le prerogative di Erwin DM che lavora con dati di qualsiasi tipo e lunghezza consentendo la gestione centralizzata dei vari modelli adottati, oltre a facilitare la progettazione di database, funzione questa che può essere automatizzata insieme alla generazione automatica di modelli.

I connettori disponibili permettono di lavorare con qualsiasi tipo di database in un’unica interfaccia grafica, sia questo installato on-premise oppure in Cloud.

I prezzi dipendono dalla versione scelta e sono comunicati a chi ne fa richiesta. Si può provare la versione Academic (per studenti e professori), si può anche richiedere una demo online.

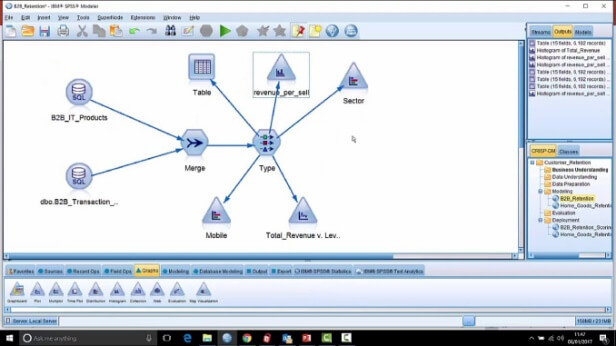

IBM SPSS Predictive Analytics

L’analisi predittiva è una disciplina avanzata che richiede il Machine learning, il data mining, la modellazione e anche principi di Intelligenza artificiale per la previsione degli eventi.

Molti tool per la Data analytics offrono elementi di analisi predittiva ma chi dovesse necessitare soprattutto di quest’ultima troverebbe giovamento indirizzandosi verso un software specializzato.

IBM SPSS Predictive Analytics è uno dei migliori prodotti disponibili e guarda a un pubblico altamente focalizzato sulla cultura dei dati e, pure essendo orientata al no-code, la piattaforma è completa nel supportare parallelamente più scenari possibili, coinvolgendo anche gli utenti meno esperti e fornendo strumenti di analisi approfondita a chi è molto addentro alle tematiche dell’analisi dei dati.

IBM fornisce altri pacchetti per l’integrazione di data modeling, statistica e analisi propriamente dette. Tutti i pacchetti messi a disposizione da IBM possono essere impiegati con dati strutturati e non strutturati. Viene impiegata anche per la sicurezza predittiva, altro tema di vitale importanza per le imprese.

I prezzi confermano la platea altamente specifica a cui il prodotto si rivolge, partono da 3.610 dollari per utente (3.350 euro circa) e arrivando a superare i 20mila dollari per le versioni più avanzate.

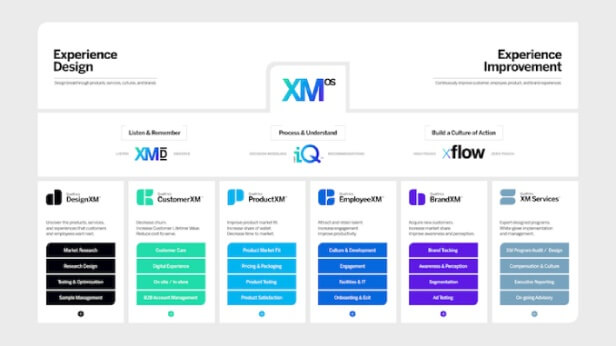

Qualtrics XM

Ci sono strumenti specifici che riguardano un solo ambito e raggiungono, nel comparto in cui si situano, livelli di operatività e qualità notevoli. È il caso di Qualtrics che guarda unicamente alle ricerche di mercato.

Un software di analisi statistica avanzata che dispone di azioni automatizzate per raccogliere dati sull’esperienza d’uso e feedback coinvolgendofornitori, partner, clienti e aspiranti tali. Si integra a sistemi di messaggistica, ai Crm aziendali, ai canali sociali e ad altri ancora.

Una soluzione mirata alla Brand experience i cui costi sono riservati a chi ne fa richiesta. Si può richiedere una demo online.

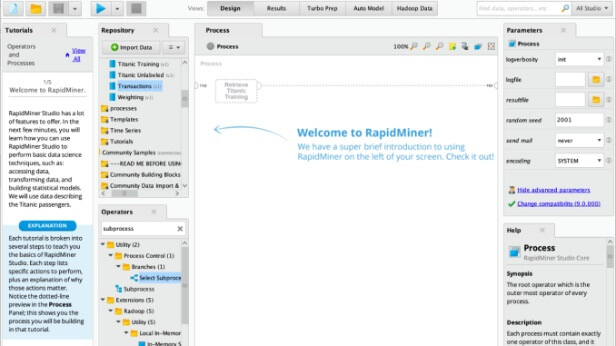

Rapidminer

La Data analytics sollecita nell’immaginario collettivo la complessità. Visione caustica non sempre condivisibile e la riprova di ciò è Rapidminer che unisce diversi prodotti per restituire una modalità semplice di progettare e implementare processi di analisi dei dati. Statistiche, visualizzazioni e esplorazione predittiva sono facilitate dagli oltre 1.000 algoritmi già pronti all’uso e la possibilità di integrare librerie di terze parti (Python, soprattutto). Questo permette di raggiungere livelli di analisi approfonditi senza grandi necessità di un intervento umano altamente specializzato.

Si può organizzare una demo online.

OpenRefine

Infine, una soluzione per chi lavora con fonti di dati che necessitano di essere trasformati e resi omogenei per potere essere archiviati in un database. La pulizia e la trasformazione dei dati in altri formati è essenziale per ogni processo di analisi ed è un compito che OpenRefine svolge in modo egregio, peraltro rispettando una formula Open source e multipiattaforma, si può usare su Windows, macOS, Linux e distro Ubuntu o Debian.

Dispone di diversi plugin per collegare dati con diversi servizi e, nel pieno rispetto della privacy, il client che si può prelevare sul sito OpenRefine (già noto a molti con il nome di Google Refine) permette di eseguire un’applicazione che funge da server direttamente laddove i dati risiedono.