L’intelligenza artificiale è sempre più vista dalle organizzazioni di tutti i settori e dimensioni come un’opportunità per trasformare il proprio modello di business, nonché per risolvere problemi cronici che pesano da anni su produttività ed efficienza. Ma un progetto AI non può essere improvvisato né tantomeno essere organizzato in tutta fretta, saltando gli step che devono essere necessariamente effettuati per far rendere al meglio i progetti. Di tutto questo si è parlato nella speciale sessione dedicata alla gestione dei dati che si è svolta all’interno del Cloud Ai Forum organizzato da IBM. Come ha messo in luce Marina Natalucci, ricercatrice degli Osservatori Digital Innovation del Politecnico di Milano l’analisi dei dati è strettamente collegata a un’altra tecnologia chiave, quella del cloud. Che come noto, ha vissuto una crescita estremamente forte nel 2020 (+30%, arrivando a quota 2 miliardi di euro di fatturato annuale), così da garantire alle imprese la necessaria continuità operativa nell’emergenza sanitaria. Circa il 17% della spesa nel cloud, vale a dire 352 milioni di euro, è destinato a tecnologie e software per l’intelligenza del dato, che consentono cioè di gestirlo e analizzarlo. In particolare, nel 2020 è decollata la spesa in soluzioni Saas, in discontinuità rispetto agli anni precedenti: dunque i dati vengono sempre più gestiti e analizzati da remoto. Ma nonostante la crescita del cloud e del Saas, non si può dimenticare la presenza nelle organizzazioni italiane di un immenso patrimonio di tecnologie di tipo legacy, frutto di investimenti realizzati nel corso degli anni. Dunque la logica deve essere soprattutto quella di un modello ibrido, che consenta alle aziende di gestire e interconnettere la grande mole di dati a disposizione, indipendentemente da dove risiedono, così da rispondere alle sfide del business e garantire così la massima efficienza.

Il peso della Data Virtualizazion

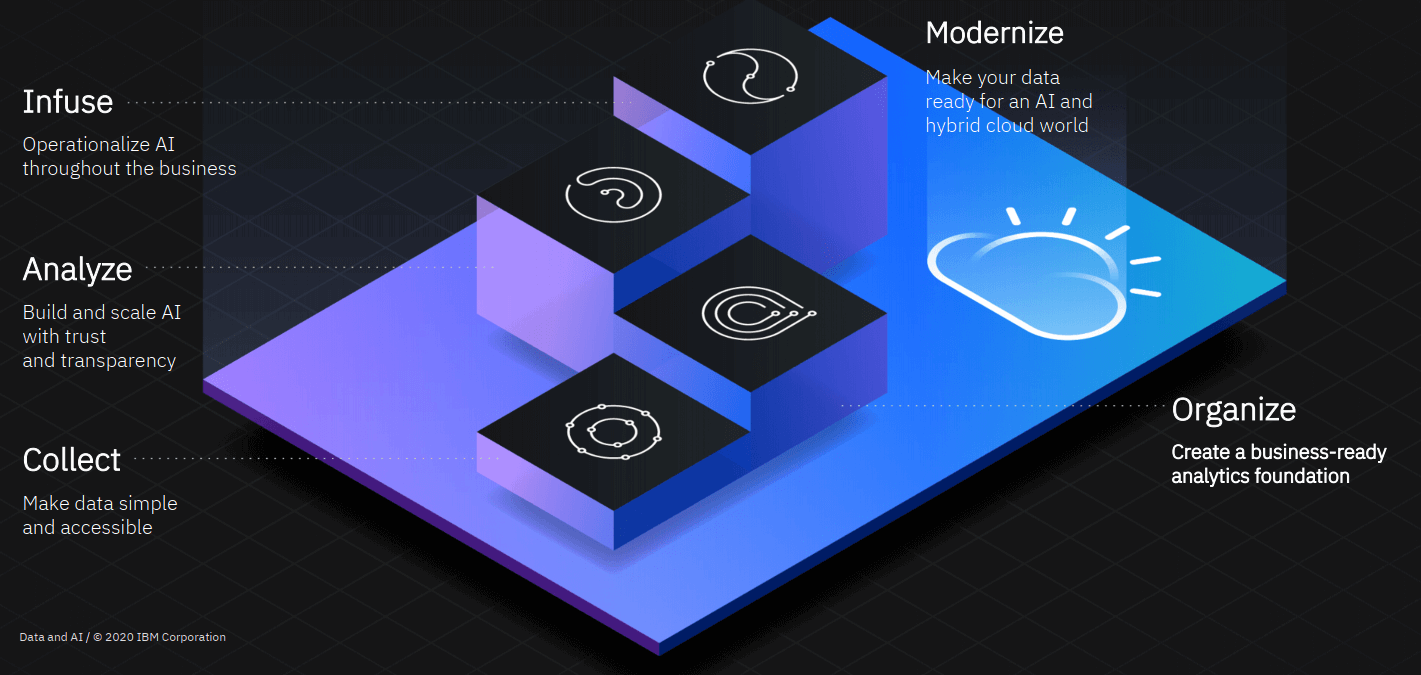

Una logica che è stata fatta propria da IBM, come raccontato da Luigi Clivati, IBM Cloud Pak for Data Sales Leader: la scelta è stata quella di puntare su un modello ibrido e aperto, partendo dalla constatazione che sempre più organizzazioni hanno a che fare con un panorama infrastrutturale di tipo multicloud. Questa concezione ispira anche la piattaforma di IBM, Cloud pak for Data, che è concepita per assicurare la massima interoperabilità tra differenti tecnologie e fonti di dati. In particolare, il concetto chiave è quello della Data virtualization: come ha raccontato Vincenzo D’Abronzo, Cloud Paka for Data Sales Leader di IBM, le organizzazioni possono contare su un unico punto a cui accedere ai dati, a prescindere dalla loro tipologia e provenienza, accedendo così alle informazioni di cui hanno bisogno a prescindere dalla loro collocazione fisica. “Le data source possono infatti essere di natura diversa, in cloud oppure on premise, entrando poi a far parte di un unico contenitore virtuale, a cui potranno attingere i “data consumer” per le proprie necessità. Tutto questo, è facile da capire, va a ridurre costi e complessità legata ai dati, risolvendo alla radice il problema della coesistenza di dati provenienti da sorgenti eterogenee. Messa in altri termini, grazie alla data virtualization diventa possibile accelerare decisamente lo sviluppo AI, sfruttando i benefici del cloud, quali elasticità e ottimizzazione. In questo modo anche organizzazioni estremamente complesse posso avere un approccio unico e unificato, in piena ottica data driven”, ha evidenziato Massimo Teratone, Data & Ai Technical Sales di IBM .

L’importanza della Data Story Telling

Ovviamente, ai fini dello sviluppo di progetti di analytics e di intelligenza artificiale, non tutti i dati sono uguali. Come ha raccontato nel corso dell’evento Najila Said, Technical Team Manager di IBM, “Quello di cui il business ha bisogno è che i dati siano trasformati per fornire risposte veloci, così da consentire l’adeguamento rapido ai cambiamenti di mercato. Allo stesso tempo i dati devono essere affidabili, non possono cioè certo trascurare il tema della qualità. Inoltre serve chiarezza: quello che i dati esprimono deve essere chiaro e comprensibile non solo ai Data Scientist”. In particolare la velocità gioca un ruolo importante nella data science: generalmente 80% del tempo viene speso per preparare i dati, mentre solo il 20% è legato all’analisi vera e propria. Eppure l’intero processo può essere velocizzato e automatizzato grazie a piattaforme come Cloud Pak for Data, che consentono peraltro alle imprese di guadagnare in agilità, rendendo possibili cambiamenti in corso d’opera. Non meno cruciale è il ruolo dell’affidabilità dei dati (senza la quale ogni progetto è destinato al fallimento) e alla chiarezza, che può essere chiamata anche data story telling: i dati devono parlare in maniera chiara ai decisori aziendali, serve una visualizzazione ordinata, in grado dunque di fornire reale valore. Ma come si può ottenere velocità, chiarezza e affidabilità? “ Per soddisfare queste esigenze abbiamo bisogno di avere a disposizione tutti gli ingredienti. Un’infrastruttura su cui poggiare i dati, ma anche un software che raccolga, analizzi i dati e li esponga nella maniera opportuna. IBM può mettere sul piatto uno dei software più performanti al mondo, Cloud pak for data, che a sua volta poggia su Red Hat open shift, permettendo cosi di sfruttare le potenzialità dell’AI su qualsiasi tipo di architettura, sia essa cloud o on premise. Garantendo peraltro l’applicazione di regole e policy che permettono di soddisfare le necessità normative. Tutto questo con un occhio di riguardo al tema dell’explainability dei dati” evidenzia Clivati.

La DataOps per la Data Governance

Ma perchè i progetti AI possano andare per il verso giusto occorre fare un passo indietro e concentrarsi sulla Data Governance. Quest’ultima, come ha messo in luce Alessandra Asaro, Data & Ai, Technical Sales di IBM, è sostenuta da 4 pilastri: conoscenza della provenienza del dato, della sua qualità, comprensione dello stesso e adeguata preparazione (ad esempio tramite pulizia/bonifica del dato). Anche saltando uno solo di questi passaggi, il rischio è che i progetti di AI caschino come un castello di carta, non permettendo il raggiungimento degli obiettivi di business. In questo senso, la strategia di IBM – come raccontato da Vincenzo D’Abronzo – risiede soprattutto nella Data Ops, che fa riferimento all’orchestrazione di persone, processi e tecnologie per fornire velocemente dati attendibili, utilizzabili nel business ai data citizen, alle operazioni, alle applicazioni e all’intelligenza artificiale. In particolare IBM DataOps consente una collaborazione agile sui dati, promuovendo la velocità e la scalabilità delle operazioni e dell’analytics durante tutto il ciclo di vita dei dati.