Si stima che entro il 2025 produrremo più di 400 exabyte al giorno (400 trilioni). Ci sarà quindi la possibilità di raccogliere un numero di dati mai visto prima, con un livello di dettaglio inimmaginabile. Questo permettà di descrivere gli individui andando ben oltre le informazioni finora disponibili. Sarà infatti possibile, mediante l’intelligenza artificiale, analizzare gli acquisti di Amazon, le ricerche di Google, i tweet, le foto di Facebook, la storia dei debiti, i film visti su Netflix etc.etc. I Big Data permetteranno di capire quali utenti sono simili ad altri (mediante clustering o profilazione), basandosi su update di stato, video visti, chiamate al telefono, messaggi di testo, acquisti e tanto altro.

L’AI renderà quindi sempre più facile individuare gruppi affini di persone. E potrà provare (a velocità machine-speed), su più componenti dei gruppi individuati, a inviare messaggi per manipolare l’individuo. Se questo meccanismo dovesse funzionare, si potrebbe usare la stessa tecnica per tutti gli appartenenti al gruppo, producendo risultati simili in un numero molto maggiore, scaldando la tecnica.

L’alterazione della realtà, oggi

Intelligenza Artificiale e Big Data possono creare un drammatico aumento nel numero di oggetti non reali che vengono considerati tali (bot, video, immagini), riducendo la percezione del reale e il rischio di mettere in dubbio tutti i contenuti, nonché possono aiutare a creare persone-fake e rendere più difficile individuare comunicazioni reali da comunicazioni-fake. Ecco alcuni esempi.

Gli shallowfake sono immagini, video o audio creati ad hoc e solitamente messi fuori contesto per passare un messaggio diverso dall’originale. I deepfake, invece, usano l’intelligenza artificale per creare immagini, video e audio facendo dire o fare cose a persone conosciute, che non avrebbero mai detto o fatto. Il tutto creando media dal nulla difficili da distinguere da video/audio reali. Gli AI-driven social bot possono comunicare con gli esseri umani come se fossero persone.

Generative Adversarial Networks, reti a due modelli separati

Una delle tecnologie che permettono i deepfake sono le GAN. Le GAN sono una classe di sistemi di machine learning composte da due reti neurali. Queste hanno due modelli di rete separati: un generatore e un discriminatore-avversario. Il generatore prende dei dati di training (ad esempio foto) e impara a ricrearli come se fossero reali. Il discriminatore tenta di distinguere il dato di training dal dato generato arbitrariamente dalla rete generatrice. All’inizio sarà facile fare questa distizione tra immagini casuali generate e immagini corrette del training, ma con il tempo la rete avversaria farà sempre più fatica a individuare le immagini del dataset di training rispetto a quelle generate dal generatore, che grazie ai feedback suoi e della rete avversaria migliorerà sempre di più. Il tutto a machine-speed, con un’alta capacità quindi di raggiungere velocemente ottimi risultati.

L’alterazione della realtà, ieri

Ciò che è oggi possibile grazie al progresso dei sistemi basati sull’AI, in realtà esiste già da molto tempo. Gli esseri umani sono sempre stati vulnerabili a meccanismi di provocazione, condizionamento o manipolazione. Nel 1960, ad esempio, in Unione Sovietica l’esercito creò un progetto denominato “Reflexive control theory” che aveva come scopo proprio quello di creare un modello che permettesse di modificare la percezione della realtà di un individuo-obiettivo. La strategia si basava sull’inviare all’individuo-obiettivo delle informazioni in modo tale da cambiare lentamente la sua percezione della realtà e quindi le sue decisioni, pur mantenendolo convinto di continuare a decidere liberamente.

In maniera simile, negli anni Settanta la Germania dell’Est capì l’importanza di “costruire” la realtà per mantenere il controllo del territorio. Il ministero della Sicurezza Interna (Stasi) estese il proprio controllo dal mondo fisico (torture ed esecuzioni) al mondo psicologico.

La Stasi chiamò questa tecnica Zersetzung, che si può tradurre come “decomposizione”. L’obiettivo era quello di raccogliere informazioni su una persona e poi utilizzarle in modo da distruggere il senso del sè sia in privato che in pubblico, per questa persona. Il metodo prevedeva di entrare nelle case degli obiettivi rubando oggetti, mandare ai propri cari foto compromettenti, screditare le persone nel posto di lavoro. Le persone quindi vedevano un progressivo decadimento della loro vita, fino ad arrivare a non riconoscere più la propria esistenza con conseguenze psicologiche non da poco.

Che cosa non è l’intelligenza artificiale

Ci sono una serie di motivi per cui scenari distopici come quelli delineati in film come “Terminator” o “Skynet” a oggi non sono realistici.

L’idea che improvvisamente un bayesiano, una rete neurale, AlphaGo, un nearest-neighbour o simile, diventino improvvisamente conscie è estremamente fantasiosa.

I metodi di AI utilizzati ai giorni nostri sono metodi che corrispondono a sistemi costruiti dall’uomo, con principi comprensibili, dotati di input e di ouput, che tipicamente hanno uno scopo e un contesto ben definito.

È complesso anche solo a pensare a delle AI generali, che sappiano fare diverse cose (dette AGI), peggio ancora a pensare che una AI costruita per riconoscere gatti o cani o cartelli improvvisamente diventi conscia di se stessa ed evolva (come?) fino a diventare un essere senziente.

Con questo non si vuole dire che non sarà mai possibile fare un AI “intelligente” tale da competere con un umano in una serie di attività, ma che ci si arrivi facendo AI specializzate a risolvere puntuali problemi reali, risulta abbastanza difficile da pensare.

Una AI più intelligente dell’uomo?

Un altro pensiero tipico associati all’evento della superAI che sarà più intelligente dell’uomo è definito Singolarità: ovvero si parla di un sistema in grado di ottimizzare se stesso, di ricablarsi e riprogrammarsi, in modo da migliorare la propria intelligenza accelerando la sua evoluzione in maniera esponenziale. In tale scenario l’umanità diventerebbe una sorta di “mosca fastidiosa” e quindi sarebbe da eliminare o semplicemente da utilizzare.

È possibile che un sistema sia in grado di ottimizzare se stesso, ma sempre nell’ottica di realizzare un determinato task specifico. Al momento, rimanendo nel mondo delle AI specializzate, è difficile che una AI diventi superintelligente, se non a riconoscere cani e gatti ad esempio.

Ma perchè allora si parla tanto di questa singolarità o si dà così credito a discorsi futuristi che vedono nel 2030 l’AI in grado di scrivere libri, comporre musica di altissima qualità etc etc

Perchè quando una tecnologia ha un potenziale inclusivo, c’è un ciclo che prevede due scuole di pensiero: ci sarà un punto di rottura oltre il quale questa tecnologia cambierà il mondo oppure ci saranno tante piccole modificazioni che cambieranno il mondo.

Di solito il primo assunto fa più rumore, quindi dire che ci sarà un Terminator entro il 2030 fa molto più notizia o impatto che dire che ci saranno entro il 2021 degli assistenti vocali specializzati su aspetti medici, che entro il 2022 l’AI permetterà di avere diagnosi mediche accurate, che entro il 2023 ecc.ecc.

La gente tende ad ascoltare molto di più gli estremi e gli alberi che crollano nella foresta, che l’erba che cresce ma che nel tempo cambia comunque il paesaggio.

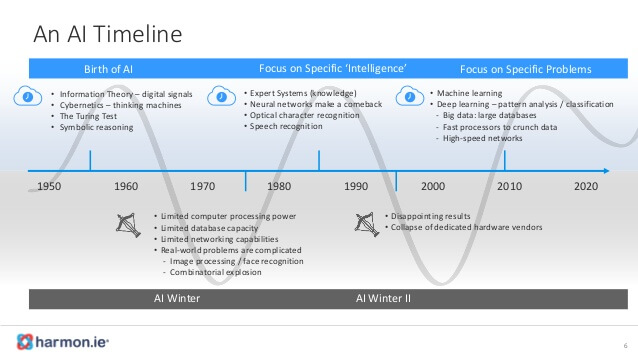

Alti e bassi dell’intelligenza artificiale

L’altra cosa che ci fa pensare di rimanere con i piedi ben ancorati per terra, è che questa è la terza “estate” dell’AI, ovvero ci sono già stati due inverni. Ovvero ci sono già stati due periodi di grande hype dell’AI, seguiti da due periodi di disillusione profonda.

In particolare negli anni ‘60 quando sono nate le reti neurali e si è cominciato a parlare di AI, si sarebbe pensato che nel 2020 avremmo vissuto in un mondo come quello descritto da Asimov, ovvero robot che fanno tutto e uomini che non lavorano più. Così non è stato. La delusione ha portato l’inverno degli anni ‘70 sull’AI.

Negli anni ‘80’ c’è stato un secondo periodo caldo, associato ai sistemi esperti, seguito dalla delusione dei risultati.

Il cliclo attuale è una terza estate, interessante per diversi aspetti.

– Big data

le moli di dati a disposizione per fare analisi sono cresciute a dismisura e queste sono fondamentali per diversi modelli, tra cui in particolare le reti neurali.

– CPU

Cpu sempre più veloci e in grado di fare calcoli paralleli (GPU) che permettono di ottimizzare il funzionamento delle reti neurali, permettendoci di passare alle Deep Network.

– Cloud

gli algoritmi grazie alle migliori connettività sono in grado di comunicare tra loro, quindi si possono avere servizi di AI as a service.

Gli obiettivi sono stati resi più reali. L’obiettivo non è costruire l’AI cosciente, ma un AI in grado di risolvere problemi concreti e utili.

Soprattutto questo ultimo punto ci fa pensare che l’AI diventerà sempre più pervasiva nelle nostre vite, perchè ora è collegata alla realtà (del resto lo è già in molti ambiti in cui risolve problemi reali).

Per questo è importante conoscerne le basi, come tecnologi ma anche come cittadini, per evitare un futuro AI-Divide, dopo il Digital-Divide.

Conclusioni

Come sempre la tecnologia può essere utilizzata in modo positivo o negativo. Tutti i tool sopra indicati permettono grandi miglioramenti, ma costituiscono anche grandi rischi.

Ci sono alcune misure a difesa che si possono attuare. Vediamo quali.

La prima misura è data da decisioni governative che mirino a controllare (punendo) certi usi della tecnologia, come ad esempio i deepfake o gli shallowfake una volta individuati.

Una seconda misura è una limitazione da parte degli stessi social network per account fasulli e notizie e immagini false, una volta individuate.

Una terza possibilità è un uso consapevole delle proprie informazioni, in modo da evitare di distribuirne troppe e troppo dettagliate. In tale modo si riduce la superficie di attacco, contenendo il numero di informazioni in possesso di un terzo e a lui utili per una manipolazione.

Un quarto punto è avere un po’ di sano scetticismo e non dare più “trust” a ciò che si vede. Purtroppo quello che vediamo, che fino a pochi mesi fa era sicuramente “vero”, ormai con deepfake e shallowfake potrebbe non esserlo più.