In una fase cruciale della ripartenza post-pandemia – una ripresa molto rapida e prorompente in certi settori -, le imprese hanno urgenza di analizzare lo scenario in cui operano e di individuare, in base ai dati, in particolare dati di qualità, su quali business o portafoglio prodotti puntare, senza perdere tempo, concentrando gli investimenti laddove servono. La Real time analytics è dunque fondamentale perché evita alle imprese il rischio di disperdere risorse preziose in mille rivoli, favorendo il raggiungimento degli obiettivi in tempo reale, riducendo il time-to-market ed ottenendo maggiore efficacia dalle azioni svolte. Sono questi i suoi principali benefici, infatti, insieme alla sua capacità di aumentare la produttività.

Le aziende devono dunque sfruttare i Big Data, integrando queste risorse all’interno di tutti i processi aziendali. Solo l’analisi dei dati in tempo reale può offrire ai manager, che devono agire prontamente, una fotografia precisa e puntuale delle tendenze in atto, cogliendo le migliori opportunità, il più velocemente possibile.

Cos’è la Real time analytics

L’analisi in tempo reale è la disciplina che applica la logica e la matematica ai dati, per prendere decisioni migliori in tempi brevi, sulla base degli insights. L’espressione Real time significa che in alcuni casi l’analisi deve essere completata in una manciata di secondi o minuti, prima dell’arrivo di nuovi dati da analizzare. La Real time analytics si suddivide in due tipologie di analisi: quella On-demand e quella Continuous.

- On-demand real-time analytics: implica la richiesta da parte di utenti o sistemi di una query che fornisce i risultati dell’analisi svolta in tempo reale;

- Continuous real-time analytics: è più proattiva ed avverte gli utenti o innesca risposte nel momento in gli eventi si verificano. Vengono definite Data master le organizzazioni, in grado di creare, elaborare e sfruttare i dati in modo proattivo, per realizzare la propria missione aziendale, raggiungendo gli obiettivi di business e generando innovazione.

Cosa significa Big Data

I big data si riferiscono a enormi quantità di dati, che occupano molto spazio di archiviazione, nell’ordine dei Terabyte. I dati rappresentano, infatti, le priorità che i capi di azienda si trovano a dover prendere in esame. Secondo una definizione dell’AgCom, la datizzazione è “quell’insieme di tecniche che consentono la conversione in formato digitale – cioè in dati – di qualsiasi cosa” (film, libri, messaggi vocali, movimenti del corpo eccetera). Se parole, geo-localizzazione, interazioni sociali e cose connesse tramite Iot si trasformano in dati, in ogni momento disseminano tracce in rete (Online footprint).

Enormi quantità di dati (in termini di volume), caratterizzati da formati differenti (in termini di varietà), archiviati ed elaborati a un ritmo (in termini di velocità) sempre crescente (spesso in tempo reale) rappresentano i Big Data, che costituiscono il fattore produttivo in un’economia data-driven, analizzata attraverso il Data mining ovvero tecniche di analisi che permettono di realizzare nuovi servizi, migliorare quelli esistenti, innovare i processi produttivi e distributivi, declinare l’offerta di tutti i prodotti e servizi (anche non digitali), sempre più in linea alle necessità di consumatori e cittadini.

Inoltre, si definiscono Big data gli asset di informazioni ad elevato volume, alta velocità e/o grande varietà in grado di essere processati, per offrire insight ai decision maker in modo da favorire l’automazione, il taglio dei tempi e costi e l’incremento di produttività.

Quali sono le piattaforme di data analytics

Le piattaforme di data analytics rappresentano un ecosistema di servizi e tecnologie che necessitano di analizzare dati voluminosi, complessi e dinamici, da recuperare, combinare insieme, e con cui interagire, da esplorare e visualizzare. Dove i dati provengono da varie fonti e non sono solo Big data, abbiamo invece a che fare coi Wide data, in sinergia con la dimensione (anche gli Small data possono offrire insights utili), varietà, se le fonti sono strutturate o no. I Wide data richiedono tecniche di X analytics.

Per analizzare i dati si possono utilizzare piattaforme cloud, basate sull’intelligenza artificiale (artificial intelligence o AI), automazione, on-device (edge) analytics e Augmentation.

Ecosistemi cloud potenziati con AI

Hanno raggiunto in questi anni un buon grado di maturità. Strumenti smart, con previsioni augmented e decision-making sono disponibili. La sfida consiste nell’assicurarsi che il proprio business sia pronto ad usufruirne.

Edge analytics

Grazie alla diffusione del cloud computing, le piattaforme sono sempre più in grado di integrare applicazioni edge nei loro ecosistemi. Ciò implica che grandi volumi e varietà di dati possano essere immagazzinati e analizzati in locale, senza bisogno di essere inviati avanti e indietro fra utente e cloud, migliorando enormemente l’efficienza. In alcuni casi, ciò aiuta a mitigare i rischi a livello di sicurezza e privacy.

Poiché le principali barriere per usare analytics avanzata sono di natura organizzativa e non tecnologica, le aziende devono scegliere le piattaforme di Data analytics in base alle proprie esigenze.

Microsoft Power BI

È una soluzione di analytics end-to-end che gode del vantaggio di avere un’interfaccia di immediata familiarità, grazie all’integrazione nell’ecosistema Office 365. Presenta licenze standard o enterprise. Power BI ha superato la soglia della prima decade e rappresenta l’analytics scelto da centinaia migliaia di azienda, ma nelle ultime versioni vanta funzionalità di automazione e augmentation in costante evoluzione.

Oracle Analytics Cloud

Il re dei database ha aggiornato la sua gamma di prodotti, alla luce delle funzionalità cloud e AI. L’aspetto più sofisticato di questa piattaforma risiede nell’uso del suo linguaggio naturale. Gestisce infatti query in 28 lingue, più di ogni altro competitor.

IBM Cognos Analytics

L’alternativa di Big Blue arriva con l’AI nella soluzione di analytics end-to-end, che consente agli utenti di chiedere e ricevere risposte alle loro query elaborate in linguaggio naturale. Invece di limitarsi a fornire grafici, può illustrare cosa significa ed evidenziare gli insights. Introduce un alto livello di automazione nel data cleansing e nella preparazione delle funzioni, dal momento che l’AI in automatico individua e ripulisce i bad data, rimuove i duplicati o evidenzia le aree in cui bisogna lavorare. Come per la soluzione targata Microsoft, può girare interamente nel cloud o essere installata in locale on-premise, a seconda delle esigenze e delle richieste di dati con cui opera.

ThoughtSpot

Si tratta di un’altra piattaforma completa. La suite permette di usare query dataset in linguaggio naturale ed enfatizza un approccio all’analytics user-friendly e pick-up-and-play. Incorpora funzionalità UI che sono familiari a chiunque usi i social media: feed curati in autonomia, real-time insights eccetera. La formula è vincente sotto il profilo dell’engagement generato dagli utenti dei social network. L’assistente AI-powered, che si chiama SpotIQ, usa il machine learning in ottica predittiva e per fornire suggerimenti ad hoc, offrendo insights trascurati o suggerendo metodi alternativi.

Qlik

È un altro player concorrente, con un’automazione machine learning-driven. Il suo Associative Engine consente agli utenti di vedere connessioni fra importanti datapoint prima di effettuare una query singola. Altro vantaggio di Qlik è il Data Literacy Project, iniziativa supportata dalla piattaforma per semplificare l’introduzione ai tool di analytics anche agli addetti non prettamente tecnici o non strettamente competenti in materia.

Apache Spark

È un open source che negli ultimi sei anni ha acquistato popolarità. L’ecosistema è ricco di estensioni e plug-in, che la rendono dedicata alla fascia enterprise: in particolare spicca MLib machine learning library. Forte della sua comunità di utenti e vendors, offre supporto e assistenza, mentre le applicazioni si adeguano ai livelli di skill dei dipendenti. Punto di forza: l’integrazione con i progetti Apache come Hadoop.

Sisense

Diventata popolare, consente di creare lavori in ambienti di collaboration dove frammentare e analizzare dati come un team, sfruttando funzionalità di Crowd Accelerated BI. L’approccio API-first e la potente ma al contempo user-friendly interfaccia browser facilitano il processo di avvio.

Talend

Scommette sull’automation in linea con le tendenze attuali nel machine learning e smart computing. Genera automated data quality e compliance nel background per fornire agli utenti accesso a insights più veloci e di qualità superiore. Anch’esso open source, ha una forte comunità da cui imparare e offre tool di esempio facilmente reperibili e template per tutto ciò che serve.

Salesforce Einstein Analytics

Definito in una classifica di Gartner ai primi posti dell’Automated analytics, la soluzione di Salesforce integrando la tecnologia Tableau, frutto di un’acquisizione, con i suoi strumenti di cloud analytics. Dall’inventore del marketing data-driven e del customer relationship management (CRM), mantiene le promesse di uno dei leader degli strumenti di standard di fascia enterprise.

SAS Vaya

Continua ad offrire una piattaforma di Business intelligence (BI) fra le più popolari al mondo. Scommette sulle opzioni di visualizzazione con la componente di Visual Analytics rafforzate con le funzionalità automation. Il suo design è perfetto per consentire un completo analytics workflow su una piattaforma unificata.

Quali sono gli obiettivi dell’analisi dei dati in tempo reale

La pandemia ha evidenziato la necessità da parte delle aziende di reinventare o accelerare la strategia data-driven. Servono le competenze per non deludere le aspettative. Oggi solo l’1% delle aziende ha uno Chief Data & Analytics Officer (Data analyst o Data scientist) responsabile sia della data governance che della data science, ma sono molto gettonati anche i profili del Data visualization expert e il Data engineer, mentre cresce lievemente la presenza del Data science manager.

Grazie all’impiego dei professionisti del settore, le imprese possono centrare gli obiettivi della Real time Analytics:

- migliorare i propri dati e la capacità di valorizzarli

- inserire nuove competenze (ricerca profili professionali con abilità di reporting e visualization)

- focalizzarsi sulla qualità dei dati real time

- investimenti tecnologici per integrare i dati in tempo reale provenienti da fonti diverse

- ottimizzare la capacità di project management nell’analitica avanzata

- investire in software di Data visualization

- intensificare il lavoro di Data science

- accelerare il cambiamento culturale data-driven

Quali sono i vantaggi della real time analytics per le aziende

L’analisi dei big data apporta alle imprese significativi benefici in due aree. La prima è legata all’esigenza di maggiore conoscenza e comprensione del comportamento della clientela (in ambito B2C), da raggiungere attraverso l’analisi di dati strutturati e non, provenienti da varie fonti, sia dirette dell’azienda che online, mediante l’analisi tradizionale in sinergia con un’analisi di tipo semantico, e tramite il collegamento di modelli e comportamenti di acquisto finalizzati a creare una maggiore fidelizzazione della clientela, oltre alla possibilità di attività di cross selling, sempre derivante da una profilazione più completa ed approfondita del cliente.

La seconda area riguarda l’ottimizzazione dei processi interni e, dunque, l’incremento della produttività aziendale, fattore dirimente per il mondo industriale e informatico, grazie alla riduzione del time-to-market e alla maggiore efficacia delle azioni svolte:

- Comprensione del comportamento della clientela

- Ottimizzazione dei processi

- Identificare il nesso fra modello di comportamento e di acquisto

- Incremento della produttività aziendale

- Fidelizzazione dei clienti

- Attività di up selling e cross selling sui clienti esistenti

- Riduzione dei rischi

- Esplorazione nuove opportunità di mercato

- Analisi: predittiva – portafoglio prodotti – Revenue forecasting

- Monitoraggio spese operative

- Analisi soddisfazione cliente

- Costruzione Cluster di clienti

- Rilevazione e prevenzione frodi

- Conformità normativa

- Ottimizzazione spesa in conto capitale.

Il mercato dei Big Data in Italia

Durante la pandemia, la società d’analisi Gartner ha previsto che organizzazioni e società, grazie a Big data e Analytics, avrebbero dovuto affrontare: disruption innovativa, incertezza radicale, ma anche nuove sfide e opportunità. Anche le aziende italiane puntano sui Big data per diventare più competitive.

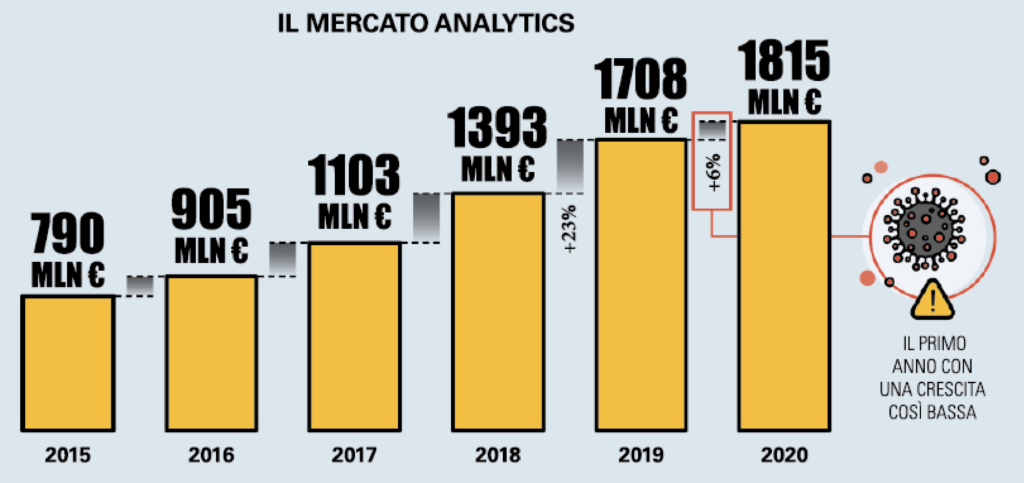

Fonte: Osservatorio Big data & Business analytics

Il mercato analytics in Italia nel 2020 si attesta su 1,815 miliardi di euro, registrando un incremento del 6% rispetto all’anno precedente, dopo il +23% registrato nel 2018 e il +26% nel 2019. Dai dati dell’Osservatorio Big data & Business analytics della School Management del Politecnico di Milano, emerge che l’emergenza Covid ha messo in risalto l’urgenza di valorizzare i dati per prendere decisioni rapidamente ed assicurare continuità di business nei momenti di crisi, ma ha anche costretto numerose aziende a rivedere i piani di investimento. Ciò ha provocato una frenata del mercato tricolore dei Big data, mentre si è ampliato il divario fra le aziende mature, che hanno razionalizzato gli investimenti riuscendo a ripensare o accelerare la strategia data-driven, e quelle più tradizionali, che hanno messo in standby o posticipato gli investimenti.

Il rallentamento della crescita della spesa relativa a prodotti e servizi è segno della necessità da parte delle imprese di reinventare il loro approccio al Big data analytics.

La spesa in Big data analytics

Nel dettaglio, a fare la parte del leone è stato l’investimento nei software (52%, +16% rispetto al 2019), soprattutto AI. Al secondo posto si piazzano i servizi, che rappresentano il 28% del mercato, seguito dal budget infrastrutturale (20%, +7%), cioè i sistemi di abilitazione agli analytics in grado di fornire capacità di calcolo e di storage.

Le risorse analytics nel cloud mettono a segno un incremento del +24%, facendo balzare questa componente al 19% della spesa complessiva (+2% rispetto al 2019).

Le banche svettano per market share (28%), seguite da manifattura (24%), Telco e media (14%), servizi (8%), Gdo e retail (7,5%), assicurazioni (7%), utility (6,5%), PA e sanità (5%).