Nel report intitolato “Top 10 Trends in Data and Analytics”, la società di analisi Gartner ha previsto che dalla fine del 2024, il 75% delle aziende passerà da un utilizzo sperimentale a un uso operativo dell’intelligenza artificiale (AI), quintuplicando la crescita del flusso di dati e delle infrastrutture di analytics. In questo contesto, nell’era della trasformazione in cloud di servizi e progetti, Databricks assume un ruolo determinante per processare big data rendere utili le informazioni estratte mediante intelligenza artificiale e machine learning.

Cos’è Databricks?

Databricks è uno strumento basato sul cloud di data science e data engineering utilizzato per processare e trasformare grandi quantità di dati, esplorandoli attraverso i modelli di machine learning. Databricks consente di trasformare i big data in informazioni dettagliate di utilità pratica attraverso gli strumenti di machine learning.

Quando è nato Databricks?

Databricks, la startup analytics e intelligenza artificiale, sostenuta anche da Microsoft, è stata fondata nel 2013 dai creatori di Apache Spark, con il coinvolgimento dell’università di Berkeley, dopo essere cresciuta in ambito accademico nei laboratori del progetto AMPLab dell’Università della California. Nel 2017 è stata annunciata l’integrazione Azure Databricks.

Databricks sviluppa Delta Lake, un progetto open source dedicato a rendere affidabili i data lake per il machine learning ed altri casi d’uso di data science.

Nel 2021 Databricks ha raggiunto la valutazione di 28 miliardi di dollari, dopo essere stata nominata leader del Quadrante magico di Gartner per le piattaforme di Data science e Machine learning, per il secondo anno consecutivo. Da febbraio, dopo aver acquisito nel 2020 Redash, è diventato partner di Google Cloud, per offrire l’integrazione fra Google Kubernetes Engine e la piattaforma BigQuery di Google.

Chi utilizza Databricks?

Sviluppatori e data scientist possono lavorare con Databricks in SQL, Python, Scala, Java e R, con un’ampia gamma di algoritmi avanzati di analytics a propria disposizione. I team sono istantaneamente produttivi con un’analisi in real-time di dataset su larga scala su topic che spaziano dal comportamento degli utenti al customer funnel.

Cos’è un data lakehouse?

Data lakehouse (magazzino di raw data in una varietà di formati) è una nuova architettura di data management aperta che coniuga la flessibilità, il taglio dei costi e scalabilità dei data lake con il data management e le transazioni ACID di data warehouse (dall’inglese letteralmente magazzino dati, abbreviato DW: una collezione o aggregazione di dati strutturati, provenienti da fonti interne operazionali ed esterne al sistema), abilitando la business intelligence (BI) e il machine learning (ML) su tutti i dati.

I Data lake sono parte integrante delle soluzioni data centriche in gran parte delle aziende, sia big company che PMI. Un Data lake – a differenza di un Data warehouse/mart dove il dato è pulito, preparato e pronto al consumo -, può essere considerato come un bacino in cui convergono vari stream di dati dove gli utenti possono immergersi per analizzarli o attingerne campioni utili ai propri scopi.

Le aziende che vogliono costruire e implementare i loro sistemi hanno accesso ai file format open source (Delta Lake, Apache Iceberg, Apache Hudi) che servono a realizzare lakehouse.

A volte si preferisce ricorrere a lakehouse invece che a un data lake per AI perché lakehouse offre data versioning, governance, sicurezza e proprietà ACID considerate necessarie per dati non strutturati.

Alcuni esempi di Databricks lakehouse

Databricks Lakehouse Platform: ha le caratteristiche dell’architettura di un lakehouse.

Azure Synapse Analytics: il servizio di Microsoft si integra con Azure Databricks ed è un esempio di lakehouse.

BigQuery e Redshift Spectrum: sono servizi gestiti con opzioni lakehouse, anche se si focalizzano principalmente su Business intelligence (BI) e altre applicazioni SQL.

Cos’è Azure Databricks?

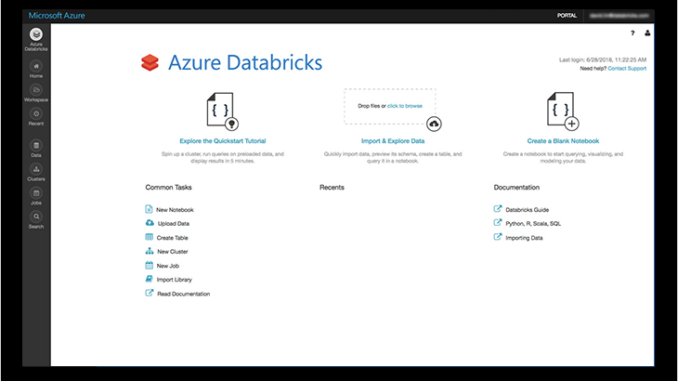

Azure Databricks è una piattaforma analytics veloce e collaborativa basata su Apache Spark. Il dataframe distribuito permette di acquisire informazioni dettagliate da tutti i dati di un’azienda e di realizzare soluzioni di intelligenza artificiale, configurando l’ambiente Apache Spark, ridimensionandolo in automatico e collaborando a progetti condivisi in un’area di lavoro interattiva. Azure Databricks supporta Python, Scala, R, Java e SQL, oltre ai framework e le librerie di data science, come per esempio TensorFlow, PyTorch e scikit-learn.

Permette di:

- elaborare dati su larga scala per carichi di lavoro in batch e di streaming;

- analizzare tutti i dati, completi e recenti; di facilitare e accelerare data science nei set di dati di grandi dimensioni, grazie ad Apache Spark, un ambiente open source veloce e ottimizzato;

- consente di accedere alle funzionalità avanzate e automatizzate di Azure Machine Learning, integrato per identificare rapidamente gli algoritmi e gli iperparametri idonei, per semplificare la gestione, il monitoraggio e l’aggiornamento dei modelli di Machine Learning distribuiti dal cloud alla rete perimetrale, e inoltre per fornire un registro centralizzato per esperimenti, pipeline di Machine Learning e modelli.

Azure Databricks modernizza il data warehouse nel cloud e permette di trasformare e pulire i dati (dopo averli spostati con Azure Data Factory e caricati in in Azure Data Lake Storage), per renderli disponibili all’analisi con Azure Synapse Analytics. L’obiettivo consiste nel combinare i dati su qualsiasi scala e acquisire informazioni dettagliate attraverso dashboard di analisi e report operativi.

Gli analytics del 4.0 diventano facili con Databricks

Gli analytics 4.0 digitali si riferiscono ai dati raccolti ovunque, dalle app ai sensori, dai dispositivi mobili agli store fisici.

Poiché Databricks semplifica l’analisi di grandi volumi di dati, usando le enormi capacità del cloud computing, e poiché Databricks è un servizio di big data analytics veloce, facile e collaborativo, dedicato al data science (la scienza che trasforma i big data in conoscenza utile a un contesto, da non confondere con AI e machine learning) e al data engineering, di conseguenza gli analytics del 4.0 diventano facili con Databricks.

La sinergia fra Big data, cloud e AI serve a facilitare l’iper-segmentazione dei clienti e l’elaborazione delle informazioni in tempo reale, in modo da progettare servizi (o progetti in cloud) personalizzati, tagliati su misura in base a ciascun profilo.