Gli elementi che costituiscono il fenomeno dell’Internet delle Cose, o IoT (Internet of Things) secondo l’espressione che va per la maggiore, sono due: una è la diffusione di oggetti ‘intelligenti’, che hanno cioè un’identità digitale (indirizzo Ip e codici identificativi) e possono interagire con l’esterno raccogliendo, trasmettendo e ricevendo dati e segnali e potendo quindi attuare azioni ‘ragionate’; l’altra è la rete di comunicazione globale, che permette a questi oggetti di entrare in relazione tra loro e con altre entità, anche ma non necessariamente umane, coordinandone e integrandone le attività. Da questa descrizione, che compendia varie definizioni dell’IoT date da osservatori, analisti e vendor It, discende un panorama di applicazioni in pratica illimitato, con effetti potenzialmente rivoluzionari in ogni campo. L’Osservatorio IoT della School of Management del Politecnico di Milano ne segue lo sviluppo in nove settori: agricoltura, produzione industriale, ambiente e città, distribuzione e controllo dell’energia, edilizia e abitazione, trasporti e logistica, auto e mezzi di trasporto, sanità e gestione degli asset (beni e mezzi di produzione). Un elenco che mostra come l’IoT riguardi praticamente ogni attività, sia economica sia sociale.

Sul lato quantitativo, in base a ricerche che stimano tassi d’incremento anno su anno che variano tra il 17% di Idc e il 23% di Ovum, diversi operatori (Fujitsu e Ptc, ad esempio) concordano su un universo di 50 miliardi di oggetti connessi entro il 2020. Oggetti gestiti da (stima Ptc) 5 milioni di apps create da quell’82% di aziende che, secondo Sap, avranno studiato soluzioni IoT per i propri prodotti e servizi già entro il 2017, cioè tra due anni.

Della rivoluzione IoT una volta tanto l’Italia non è affatto una ‘follower’. Al contrario, il già citato Osservatorio del Polimi ha calcolato per gli anni 2012, 13 e 14 tassi d’incremento sul precedente periodo rispettivamente del 25, 20 e addirittura 33% per gli oggetti connessi tramite rete cellulare, la tipologia IoT più diffusa nel Paese. Una parte di questa crescita è certamente dovuta a fattori particolari, come appunto la diffusione della rete cellulare a scapito della fibra ottica, che spinge le applicazioni IoT mobili (l’Italia è il paese che ha il record di diffusione dei veicoli monitorati da ‘smart box’), ma non dimentichiamo che il nostro sistema produttivo è essenzialmente manifatturiero e formato da imprese piccole ma dinamiche e ricettive verso le nuove tecnologie, il terreno di crescita ideale per l’IoT. Se poi si pensa che fino all’anno scorso questo sistema era ancora in crisi economica è probabile che il tasso di sviluppo dell’IoT si mantenga molto elevato anche nel prossimo quinquennio.

Le analisi che creano valore

Le tecnologie che realizzano l’IoT si possono considerare secondo uno schema che vede al centro la rete di comunicazione, sotto di questa le soluzioni hardware e software inserite negli oggetti per renderli ‘smart’ e sopra la piattaforma software per l’interconnessione e la gestione dei dispositivi ‘smart’ in modo che le informazioni sulla loro vita operativa (cioè su come funzionano e come sono usati) si possano trasformare in nuovi processi di business o integrarsi in quelli esistenti. Come è descritto in dettaglio nell’articolo “Internet of Things: Ptc è pronta alla sfida”, questa piattaforma è formata da soluzioni quasi interamente software delegate a mantenere la connettività, garantire la sicurezza dei dati scambiati sulla rete, gestire gli oggetti connessi, analizzarne la operatività e sviluppare applicazioni a supporto dei processi di business.

Considerando questi cinque compiti dal punto di vista del valore creato per l’impresa, si vede subito come lo stack tecnologico si possa dividere in una parte ‘bassa’ e una ‘alta’. Dalla prima dipendono il corretto funzionamento, la sicurezza e il controllo della rete di relazioni che costituisce l’IoT, cose ovviamente essenziali ma dallo scarso valore aggiunto. Paragonabili, per dire, al mantenimento operativo e all’efficientamento del data center. Una volta che queste siano assicurate entra in gioco la parte ‘alta’ della pila, quella che analizzando dati e relazioni estrae informazioni sulle quali il business potrà realizzare applicazioni che migliorano la qualità dei prodotti e/o il servizio che danno ai loro utenti, seguendoli nella loro vita anche dopo che sono usciti dalla fabbrica e consegnati al cliente. È sulle analytics, in conclusione, che l’IoT può mantenere la sua promessa di valore.

Fonte: Forrester Research

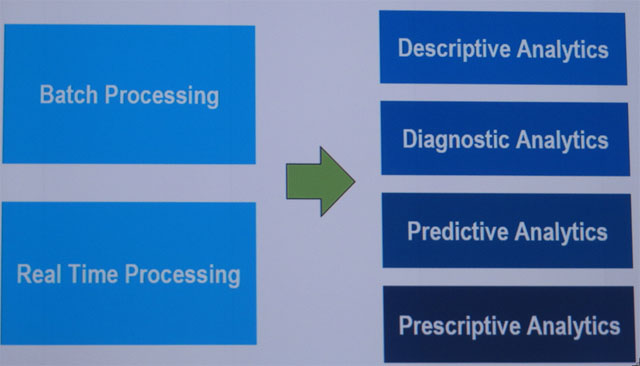

Le analisi che una piattaforma IoT deve poter eseguire sono di quattro tipi: descrittive, diagnostiche, predittive e prescrittive.

- Le analisi descrittive, come dice il nome, ricavano dalla mole dei dati sugli oggetti e sulle relazioni tra questi e i loro utenti un quadro della situazione, reso comprensibile ad analisti e uomini di business tramite report e ‘cruscotti’ grafici di facile lettura. Fanno, insomma, le stesse cose della BI, ma sulle attività delle ‘cose’ anziché su quelle del business.

- Le analisi diagnostiche – Con la diagnostica si fa un passo avanti perché oltre a dare il quadro della situazione forniscono informazioni sulle cause che l’hanno generato. Per spiegarci con un banale esempio, un’analisi diagnostica è quella che fa un buon guidatore quando, vedendo che al salire di giri del motore la spia della batteria resta accesa, ne deduce che si possa essere rotta la cinghia dell’alternatore.L’analisi diagnostica sfrutta una base di conoscenza sul prodotto e la sua operatività che a sua volta abilita l’analisi predittiva.

- Le analisi predittive – È quella che fa ancora il nostro l’automobilista se, vedendo accendersi la spia dell’olio e dedotta da ciò la mancanza di lubrificante prevede l’imminente grippaggio del motore. Le analisi predittive si stanno affacciando solo ora nelle attività di business, ma in quelle industriali sono presenti da tempo, sviluppate per prevedere rotture e malfunzionamenti di macchinari e impianti e permettere interventi di manutenzione preventiva (che sarà, come si sostiene da più parti, la “killer application” di tutta la IoT). Esempi di sistemi del genere, che anticipano i concetti dell’IoT, sono Maximo di Ibm, le cui funzioni fanno parte dell’ampia offerta di Enterprise asset management di Big Blue, e Predix di GE Software, anch’esso concepito in ottica di Eam per la gestione delle turbine e dei motori General Electric e poi sviluppato e proposto da GE come piattaforma per l’IoT industriale.

- Le analisi prescrittive – L’analisi prescrittiva è infine quella che, stabilite le cause e previste le conseguenze di un problema, suggerisce e in qualche caso attua direttamente le necessarie contromisure. La fa il nostro bravo guidatore se all’accendersi della spia dell’olio spegne subito il motore. Si tratta di un tipo di analisi già sviluppato in quegli ambiti, sia industriali sia di altro tipo, dove le informazioni in gioco sono alquanto omogenee, come nei servizi finanziari. Se l’analisi delle operazioni su una carta di credito mostra un’irregolarità rispetto ai comportamenti tipici del titolare parte prima una mail di segnalazione e poi una telefonata al cliente da parte dell’operatore umano. Nella IoT il discorso è più difficile, per la mole e l’eterogeneità dei dati in gioco, ma è nei piani dei grandi fornitori. L’obiettivo, come è stato descritto in un recente evento Ptc, è quello di realizzare una piattaforma che permetta di far convergere e legare tra loro le attività analitiche e quelle di controllo dei processi operativi volgendole entrambe alle dinamiche relative al mercato e ai consumatori. Il concetto è molto simile a quello di ‘digital enterprise’ sviluppato da tempo da Software AG, società per molti versi anticipatrice dei modelli di business che integrano analytics e operations e la cui proposta di piattaforma IoT (che tra l’altro ha una forte presenza in Italia) ci appare oggi tra le più avanzate.

Quattro ostacoli da superare

Per trarre valore di business da una piattaforma IoT bisogna, come s’è visto, raccogliere, archiviare, elaborare ed analizzare i dati da questa generati. Non è affatto un compito facile. L’insieme dei dati che giungono dai dispositivi connessi può rapidamente arrivare a livelli impressionanti per volume e per varietà. Pensiamo, per esempio, allo smartphone che abbiamo in tasca, un oggetto così comune che non si pensa nemmeno a vederlo come un dispositivo IoT. Ma lo è a pieno titolo: connesso ai sistemi analitici e transazionali del fornitore di servizi, contiene accelerometri, Gps, ricettori audio e video e altri sensori oltre allo stesso touch-screen, che ogni secondo e in modo del tutto trasparente all’utente, se non per l’esaurirsi della batteria, inviano dati che analizzati in tempo reale servono a far fare business (e che business!) alla Telco e ai suoi partner commerciali. Se passiamo a un oggetto complesso come un’automobile, dove l’elettronica è da tempo la componente di maggior valore, o un jet, dove l’analisi predittiva e descrittiva di ogni apparato è vitale per la manutenzione e la sicurezza dei voli, i sensori crescono di più ordini di grandezza creando data-set con migliaia di variabili per record. Non è detto che da tutti questi dati si possano trarre informazioni importanti o comunque utili, ma non lo si può sapere finché non sono analizzati, per cui vanno in ogni caso raccolti e memorizzati.

Fonte: Ptc

Il volume dei dati è però solo il primo dei problemi che deve affrontare un sistema analitico per l’IoT. Altre tre caratteristiche ne rendono il compito particolarmente impegnativo e sono: la varietà di formati, la varietà di flusso e la decadibilità che la maggioranza di questi dati presenta. Il primo di questi tre punti è anche il più critico, nel senso che è quello per il quale al momento non si prospetta una vera soluzione. Non vi sono infatti formati standard per i dati IoT, che possono presentarsi in pacchetti strutturati in forma alfanumerica ma formattati con regole diverse e/o in flussi di codice binario analoghi a quelli dei file audio e video. Molti formati, specie per i sensori industriali di temperatura, pressione, vibrazioni e altro, sono stati definiti da grandi vendor Cad/Cam e Plm, come Dassault, GE e Siemens, che oggi puntano ad estendersi dal manufacturing alla IoT. Poterne mantenere il controllo dà un vantaggio competitivo, e sebbene alcuni di questi fornitori (come la già citata Ptc) promuovano accordi in merito, è difficile che si possa giungere a breve a standard universalmente accettati.

Il secondo problema è la varietà dei flussi. Mentre alcuni sensori trasmettono dati in flusso continuo, come i localizzatori Gps, altri li emettono solo in seguito a un cambiamento di stato, come termostati, pressostati e simili. Poiché in un dispositivo connesso di regola coesistono entrambi i tipi di sensori il flusso dati che ne proviene è variabile, con imprevedibili picchi di volume. E se certe rilevazioni, come i consumi di energia per fascia oraria, sono in parte prevedibili, è chiaro che la banda della rete e l’infrastruttura a supporto delle analisi deve essere dimensionata per reggere improvvisi aumenti di volume senza che ciò ne rallenti in alcun modo la velocità. Infatti, e siamo al terzo punto, la natura dei dati IoT non è tale per cui si possano memorizzare per essere analizzati in seguito. O lo è solo in minima parte. Per evitare rischi imminenti, cogliere opportunità sfuggenti o anche solo ottimizzare la gestione del business con decisioni e interventi rapidi ma ragionati, bisogna che i dati rilevati siano analizzati subito. Possibilmente, man mano che arrivano dai dispositivi. Altrimenti il loro valore informativo decade. Non servono più. Ciò è ben chiaro a chi si è sempre occupato di sistemi industriali, dove cogliere i problemi mentre questi si verificano o anche prima è essenziale. Ma se si vogliono sfruttare le opportunità dell’IoT in ogni tipo d’impresa il concetto deve passare anche alle analisi degli eventi di business. Occorre quindi pensare a sistemi capaci di svolgere analisi anche complesse su grandi volumi di dati in tempo reale o quasi.

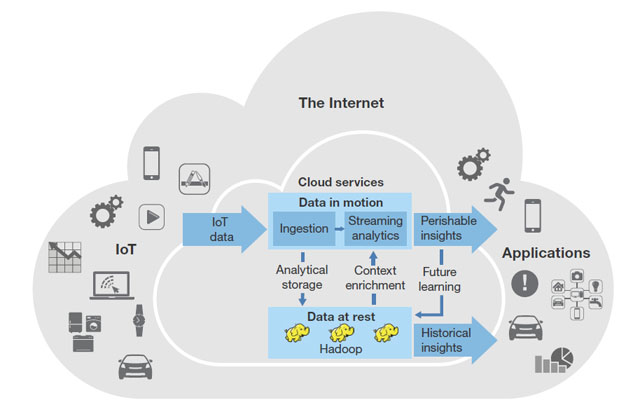

Hadoop, streaming e cloud

Fonte: Ptc

Le quattro classi di analisi che deve poter svolgere una piattaforma IoT si possono dividere in due gruppi secondo il tipo di elaborazione richiesto: descrittive e diagnostiche, eseguibili in batch in quanto poco legate al fattore-tempo, e predittive e prescrittive, che per essere utili vanno svolte in contemporanea agli eventi. La soluzione che si sta imponendo per il primo gruppo, che è anche quello che opera sul maggior volume di dati, è Hadoop, che come sappiamo comprende sia un file system distribuito sia un framework che assegna dati e carichi di lavoro a più nodi di calcolo. Questi si possono aggiungere man mano che il volume dei dati e delle relative analisi cresce, scalando il sistema in modo lineare. A parte l’implementazione di soluzioni Hadoop ‘on premises’, che molte grandi imprese hanno adottato, tutte le distribuzioni commerciali del software (di Cloudera, Ibm, Pivotal e altri) possono girare in ambiente cloud pubblico, richiedendo solo interventi d’integrazione con gli specifici tool aziendali di analisi e di gestione del provisioning. Se la sicurezza dei dati è prioritaria si può infine ricorrere ai servizi Hadoop su cloud privato offerti da Amazon e Microsoft Azure.

Per il secondo gruppo, cioè per le analisi dei dati decidui, la soluzione è lo streaming analytics, l’analisi in tempo reale sul flusso dei dati in arrivo. Piattaforme complete nelle funzionalità analitiche e maturate dall’esperienza presso gli utenti sono offerte da molti vendor (Ibm, Informatica, Sap, Sas, Software AG e Tibco tra gli altri) con possibilità di deploying sia in casa che su cloud privato. Stanno però comparendo anche servizi di streaming analytics su cloud pubblico, come Kinesis, introdotto da Amazon quasi due anni fa, Cloud Dataflow di Google, presentato l’anno scorso, e Azure Streaming Analytics di Microsoft, annunciato a fine 2014 e dal giugno di quest’anno disponibile per una prova gratuita presso gli utenti. Secondo Forrester questi servizi permettono di realizzare applicazioni analitiche ma mancano di strumenti di sviluppo avanzato paragonabili a quelli delle piattaforme streaming già citate. Ancora per Forrester, un’opzione molto interessante è data dalle analisi in real-time eseguibili direttamente sui cluster Hadoop. Data Torrent fornisce una piattaforma streaming che può essere installata su un server Hadoop preesistente funzionando in modo nativo. Discorso per certi versi simile vale per Apache Spark una piattaforma open-source di calcolo in cluster dotata di Api per applicazioni analitiche di base che girano direttamente su Hadoop. Si possono infine considerare Apache Samza e Apache Storm, soluzioni open-source che, con differenti approcci architetturali nel data-streaming, indirizzano entrambe le analisi in tempo reale.

Concludiamo osservando come buona parte delle soluzioni streaming siano disponibili anche come servizi cloud. Si tratta di un aspetto importante non solo per i vantaggi dati dalla possibilità di scalare le applicazioni senza investimenti infrastrutturali, cosa di cui abbiamo tante volte scritto, ma per la possibilità di poter provare il valore dell’IoT nella propria realtà senza affrontare un rischio imprenditoriale troppo elevato.

| Allarme sicurezza per le vetture connesse Charlie Miller e Chris Valasek, esperti di sicurezza presso Twitter e IOActive Miller, hanno controllato a distanza una Jeep Cherokee penetrando nel sistema elettronico di gestione del veicolo attraverso la connessione wireless UConnect. Ovviamente, dato che l’esperimento è stato fatto allo scopo di sensibilizzare Case automobilistiche e Ministeri dei trasporti sulla sicurezza di vetture che di fatto si stanno trasformando in siti Web con le ruote, nulla è stato detto sulla falla nel sistema di protezione di UConnect, adottato da milioni di auto del Gruppo Fca. Fiat Chrysler Automobiles, cui appartiene il brand Jeep, ha dichiarato di star esaminando la questione per prendere le contromisure necessarie, stigmatizzando però la decisione di pubblicare il risultato del test in quanto potrebbe spingere all’emulazione con gravi conseguenze sulla sicurezza. |

Per maggiori informazioni: IoT, il mercato in Italia e gli strumenti del fare