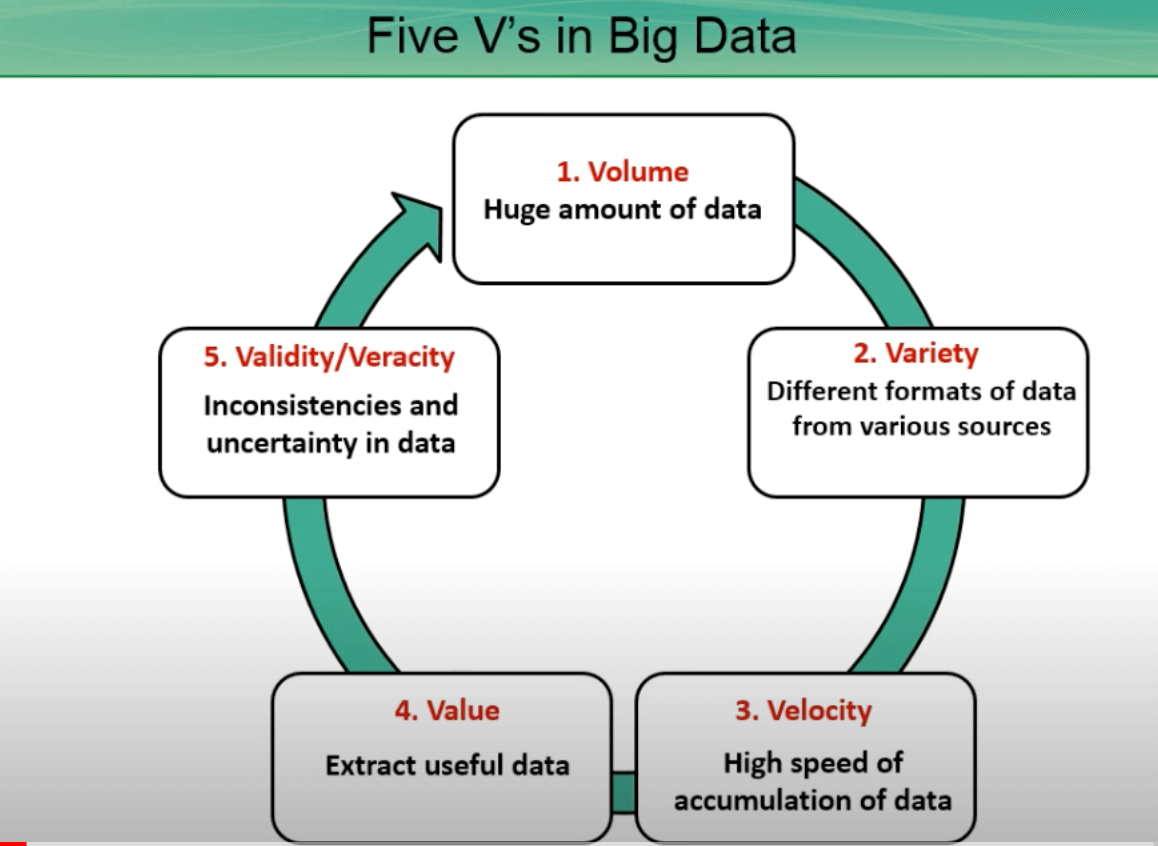

Le 5 V dei Big data sono volume, varianza, velocità, veridicità e valore. Prendono l’appellativo dal titolo del report del 2001 a firma di Doug Laney, all’epoca vicepresidente e Service Director dell’azienda Meta Group, sulle 3 V dei Big data; esse definivano i Big data in base a tre peculiarità (volume, velocità e varietà), cui, in seguito, si sono aggiunti altri due parametri. Secondo la definizione di Gartner, con il termine Big data ci si riferisce a risorse informative caratterizzate da enorme volume, elevata velocità di produzione e grande varietà tali da richiedere tecnologie e metodi analitici specifici per l’estrazione di valore o conoscenza.

Ecco cosa sono le 5 V dei Big data e come gestirle in maniera efficace e con quali strategie, per sfruttare il potenziale dei dati e trarne vantaggio nel contesto della trasformazione digitale che le aziende stanno affrontando per essere competitive.

Indice degli argomenti

Le 5 V dei Big data: cosa sono e perché sono importanti

Le 5 V dei Big data sono un concetto che rappresenta le caratteristiche principali dei dati generati in grandi quantità e velocità. Queste cinque V sono: volume, varianza, velocità, veridicità e valore. Sono variabili che descrivono cinque caratteristiche dei Big data.

Le 5 V dei Big data sono importanti perché rappresentano le sfide e le opportunità associate alla gestione e all’analisi di grandi moli di dati. Comprendere e gestire questi aspetti è cruciale per trarre vantaggio dal potenziale dei dati e ottenere un vantaggio competitivo nell’era della digital transformation.

5 V Big data: Volume, Varianza, Velocità, Veridicità e Valore

Il volume si riferisce alla vasta quantità di dati generati. I Big data si contraddistinguono per le loro dimensioni, che possono essere molto superiori rispetto ai dati tradizionali. La gestione e l’analisi di grandi volumi di dati richiedono infrastrutture e strumenti appositi.

La velocità indica la velocità con cui avviene la generazione e raccolta dei dati. Nel contesto dei Big data, i dati possono essere generati in tempo reale o in alta frequenza. La capacità di elaborare e analizzare i dati in real-time diventa quindi cruciale. Lo scopo è di ottenere informazioni utili e reattività nelle decisioni aziendali.

La varianza riguarda la diversità dei tipi di dati presenti nel contesto dei Big data. I dati possono provenire da diverse fonti, come social media, sensori, dispositivi mobili, database aziendali, e possono essere: strutturati, non strutturati o semi-strutturati. La gestione e l’analisi di questa varietà di dati richiede soluzioni flessibili e adattabili.

La veridicità concerne la qualità e l’affidabilità dei dati. Nel contesto dei Big data, è importante garantire che i dati raccolti siano accurati, completi e privi di errori. È necessario implementare processi di controllo della qualità per assicurarsi che i dati siano affidabili e che le informazioni ottenute siano valide.

Il valore infine rappresenta il potenziale valore che può essere tratto dai dati. I Big data offrono l’opportunità di analizzare e sfruttare i dati per ottenere informazioni preziose, identificare tendenze, modelli e correlazioni, migliorare la presa decisionale, individuare nuove opportunità di business e offrire un’esperienza personalizzata ai clienti.

Big Data: come gestire le 5 V per ottenere risultati efficaci

Per gestire efficacemente le 5 V dei Big data e ottenere risultati efficaci, è necessario adottare un’approccio strategico e pianificato.

Gestire efficacemente le 5 V dei Big data richiede, in conclusione, una combinazione di tecnologie, processi e competenze. È importante avere una strategia ben definita e adattabile alle esigenze mirate dell’organizzazione o dell’azienda. Ecco alcuni suggerimenti.

Volume

Per la gestione del volume, bisogna investire in infrastrutture adatte. Occorre assicurarsi di avere la capacità di archiviare e elaborare grandi volumi di dati. Ciò potrebbe richiedere l’adozione di tecnologie come il cloud computing o l’implementazione di soluzioni di storage scalabili.

Inoltre conviene utilizzare tecniche di compressione dei dati. Per ridurre l’impatto del grande volume di dati, è possibile utilizzare tecniche di compressione per ridurne la dimensione senza perdere informazioni significative.

Velocità

Per gestire la velocità, è fondamentale implementare soluzioni di elaborazione in tempo reale: se i dati vengono generati e raccolti ad alta velocità, è fondamentale implementare soluzioni che consentano di elaborarli in tempo reale. Ciò può includere l’utilizzo di strumenti di streaming analytics o di piattaforme di elaborazione dati in tempo reale.

Inoltre bisogna sfruttare l’automazione. L’automazione può infatti aiutare a ridurre il tempo necessario per l’elaborazione e l’analisi dei dati. L’implementazione di processi automatizzati può garantire una maggiore velocità di risposta alle richieste di analisi.

Varianza

Nella gestione della varianza, conviene utilizzare strumenti di data integration: per gestire la varietà di dati, è possibile utilizzare questi strumenti che consentono di combinare dati provenienti da diverse fonti e formati.

Occorre inoltre implementare tecnologie di analisi avanzate. Per affrontare la complessità dei dati non strutturati, come testi, immagini o video, è inoltre possibile utilizzare tecnologie di analisi avanzate come il Natural language processing o la computer vision.

Veridicità

Nella gestione della veridicità, si consiglia di implementare processi di controllo della qualità: è fondamentale implementare processi di controllo della qualità dei dati per garantire che siano accurati e privi di errori. Ciò può includere l’utilizzo di tecniche di data cleaning o di algoritmi di rilevamento degli errori.

Occorre poi garantire la sicurezza dei dati. Per mantenere la veridicità dei dati, è dunque importante implementare misure di sicurezza adeguate per proteggerli da accessi non autorizzati o modifiche indebite.

Valore

Infine, per gestire la quinta V, il valore, bisogna definire obiettivi chiari: prima di iniziare l’analisi dei dati, è importante definire obiettivi chiari e specifici per ottenere il massimo valore dai dati.

Dunque è necessario utilizzare strumenti di analisi avanzati. Per estrarre valore dai dati, bisogna utilizzare strumenti di analisi avanzati. Esempi: l’apprendimento automatico, l’intelligenza artificiale o la visualizzazione dei dati.

Occorre integrare i risultati nelle decisioni aziendali. I risultati dell’analisi dei dati devono infatti essere integrati nelle decisioni aziendali per ottenere un impatto concreto. Ciò richiede una collaborazione tra i team di analisi dei dati e i responsabili delle decisioni aziendali.

L’importanza delle 5 V nel contesto dei Big data

Le 5 V dei Big data sono importanti perché rappresentano le caratteristiche distintive dei dati generati in grandi quantità e velocità nel contesto dei Big data. Ecco perché sono importanti:

Il grande volume dei dati è una delle caratteristiche principali dei Big data. L’importanza del volume risiede nella quantità di informazioni disponibili. Maggiore è il volume dei dati, infatti, superiori sono le opportunità di ottenere informazioni significative e rilevanti per l’analisi e il processo decisionale.

La velocità con cui i dati vengono generati e raccolti è inoltre fondamentale nel contesto dei Big data. La sua importanza sta nell’opportunità di ottenere informazioni in tempo reale. Ciò consente di prendere decisioni più rapide e reattive, adattandosi alle dinamiche e alle esigenze del business.

La varietà dei tipi di dati presenti nel contesto dei Big data è cruciale. Permette infatti di ottenere una visione completa e approfondita delle informazioni. I dati possono provenire da fonti diverse e possono essere strutturati, non strutturati o semi-strutturati. La varietà è importante per la possibilità di combinare e analizzare dati eterogenei, ottenendo così una prospettiva più completa e dettagliata.

L’accuratezza e l’affidabilità dei dati sono fondamentali per ottenere risultati validi e affidabili. L’importanza della veridicità risiede nella necessità di garantire che i dati siano corretti, completi e privi di errori. Solo dati veritieri possono fornire informazioni accurate per prendere decisioni informate e basate su fatti.

Estrarre valore dai dati

Il valore dei dati è infine l’obiettivo finale dei Big data. L’importanza del valore consiste nella possibilità di estrarre informazioni significative e utili dai dati per trarre vantaggio competitivo, identificare opportunità di business, migliorare l’efficienza operativa, personalizzare l’esperienza del cliente e innovare i processi aziendali.

In sintesi

Le 5 V dei Big data rappresentano le sfide e le opportunità associate alla gestione e all’analisi dei dati. Comprenderne e gestire questi aspetti consente di sfruttare il potenziale dei dati e trarre vantaggio nel contesto dell’era digitale.

Strategie per affrontare le 5 V dei Big data con successo

Per affrontare con successo le 5 V dei Big data, è necessario adottare una serie di strategie e approcci. Essi richiedono di combinare insieme competenze tecnologiche, metodologie di gestione dei dati e una cultura aziendale orientata all’utilizzo dei dati per prendere decisioni informate.

Volume

Occorre implementare infrastrutture scalabili. Bisogna assicurarsi di avere una capacità di archiviazione e di elaborazione dei dati adeguata al grande volume. L’utilizzo di tecnologie come il cloud computing può essere utile per scalare le risorse in base alle esigenze.

Appare necessario utilizzare tecniche di archiviazione efficienti, adottando anche soluzioni di compressione o di archiviazione dati ottimizzate per ridurre l’impatto del grande volume e migliorare le prestazioni.

Velocità

Bisogna utilizzare tecnologie di elaborazione in tempo reale: implementare soluzioni che consentono di elaborare i dati in tempo reale, come streaming analytics o piattaforme di elaborazione dati in tempo reale. Ciò consente di ottenere informazioni tempestive per prendere decisioni immediate.

Occorre sfruttare l’automazione relativamente ai processi di acquisizione, all’elaborazione e all’analisi dei dati. Automatizzare può infatti contribuire a ridurre i tempi di risposta e a ottenere risultati più rapidamente.

Varianza

Una strategia consiste nell’utilizzo degli strumenti di data integration: adottare soluzioni che consentono di integrare e combinare dati provenienti da diverse fonti e formati. Ciò permette di ottenere una visione più completa e approfondita dei dati.

Implementare tecnologie di analisi avanzate consente di utilizzare strumenti di analisi avanzati come il natural language processing, l’apprendimento automatico o la computer vision per gestire dati non strutturati o semi-strutturati.

Veridicità

Implementare processi di controllo della qualità dei dati: definire procedure per garantire l’accuratezza e l’integrità dei dati. Ciò può includere attività di data cleansing, verifica della coerenza e validazione dei dati.

Garantire la sicurezza dei dati è fondamentale, implementando misure di sicurezza per proteggere i dati da accessi non autorizzati o modifiche illecite. Ciò include l’utilizzo di crittografia, autenticazione e autorizzazioni adeguate.

Valore

Definire obiettivi chiari permette di stabilire obiettivi specifici per l’analisi dei dati, in linea con le esigenze e le priorità dell’organizzazione. Questo aiuta a focalizzarsi sui risultati desiderati.

Occorre utilizzare strumenti di analisi avanzati. L’adozione di tecnologie di analisi avanzate permette di estrarre valore dai dati, come modelli predittivi, analisi delle reti sociali o visualizzazione dei dati.

Bisogna integrare i risultati nelle decisioni aziendali: assicurarsi che i risultati dell’analisi dei dati siano integrati nelle decisioni aziendali, coinvolgendo i responsabili delle decisioni nel processo di analisi e interpretazione dei dati.

Come garantire la veridicità dei dati

Assicurare la veridicità dei dati nell’ambito delle 5 V dei Big data è fondamentale per ottenere risultati accurati e affidabili. Ecco come garantire la veridicità dei dati: validazione dei dati (verifica di eventuali errori o anomalie nei dati, data cleaning e verifica della coerenza tra i dati provenienti da diverse fonti); controllo della qualità dei dati (accurati e completi); sicurezza dei dati; tracciabilità dei dati.

5 V Big Data: come sfruttare la velocità e il valore dei dati

A spingere la velocità, ingranando la quinta, è la diffusione di dispositivi equipaggiati sensori (IoT, smart home eccetera) dedicati alla raccolta di dati in tempo reale. Questa proliferazione di dispositivi con sensori è un vero e proprio fattore di accelerazione.

Le aziende devono dunque cimentarsi in nuove sfide. Non solo raccogliere i dati, attraverso un’acquisizione sempre più veloce, ma anche analizzando i big data in tempo reale (attraverso la real-time analytics).

L’obiettivo delle aziende consiste infatti nel velocizzare il processo decisionale, rendendolo il più tempestivo possibile, offrendo ai decision-maker la maggiore rapidità e immediatezza di azione e reazione agli eventi che si verificano in ogni business.

Utilizzare il valore dei dati

Per sfruttare il valore dei dati nel contesto dei 5 V del Big Data, è necessario seguire alcune strategie chiave: occorre definire obiettivi chiari; bisogna acquisire e integrare dati di qualità; utilizzare strumenti di analisi avanzati; sfruttare la visualizzazione dei dati; integrare i risultati nelle decisioni aziendali.

Sfruttare il valore dei dati richiede un approccio strategico e sistematico. È importante investire nelle competenze, nelle tecnologie e nelle risorse necessarie per gestire, analizzare e interpretare i dati in modo efficace. Inoltre, è essenziale creare una cultura aziendale orientata all’utilizzo dei dati, in cui l’analisi dei dati sia considerata un’attività cruciale per il successo aziendale.

Obiettivi chiari

Prima di tutto, è importante definire obiettivi specifici e misurabili per l’utilizzo dei dati. Questi obiettivi dovrebbero essere allineati agli obiettivi aziendali e alle sfide che si desidera affrontare. Ad esempio, è possibile migliorare l’efficienza operativa, ottimizzare la customer experience o identificare nuove opportunità di business.

Acquisire e integrare dati di qualità

Per ottenere risultati di valore, è fondamentale acquisire e integrare dati di alta qualità provenienti da fonti diverse. Ciò richiede l’implementazione di processi di controllo della qualità dei dati, come il data cleansing e la validazione dei dati. È inoltre importante sviluppare una strategia di integrazione dei dati per combinare e correlare informazioni provenienti da diverse fonti.

Strumenti di analisi evoluti

Al fine di estrarre valore dai dati, è necessario utilizzare strumenti di analisi avanzati come il machine learning, l’intelligenza artificiale e l’analisi predittiva. Questi strumenti consentono di identificare modelli, correlazioni e tendenze nascoste nei dati, fornendo informazioni preziose per prendere decisioni informate.

Visualizzazione dei dati

La visualizzazione dei dati è un modo potente per comunicare e interpretare le informazioni. Utilizzando grafici, tabelle e dashboard interattive, è possibile trasformare i dati complessi in visualizzazioni intuitive e facilmente comprensibili. Ciò consente di identificare facilmente i modelli e le relazioni, facilitando l’approccio decisionale.

Risultati integrati nel processo di decision-making

Infine, è fondamentale integrare i risultati dell’analisi dei dati nelle decisioni aziendali. Coinvolgere i responsabili delle decisioni nel processo di analisi e interpretazione dei dati e fornire loro informazioni chiare e pertinenti per supportare le decisioni strategiche. Inoltre, è importante monitorare e valutare l’impatto delle decisioni prese sulla base dei dati per continuare a migliorare e ottimizzare i processi.