A febbraio 2021 è previsto il lancio della missione di rifornimento verso la Stazione Spaziale Internazionale ISS della capsula Cygnus NG-15 con a bordo lo Spaceborne Computer-2 (SBC-2) prodotto dalla Hewlett Packard Enterprise (HPE), un avanzato sistema di edge computing commerciale che darà agli astronauti la possibilità di sperimentare sistemi di calcolo più rapidi di quelli oggi presenti a bordo. Sebbene nell’immaginario collettivo i computer presenti nello spazio siano considerati il meglio del meglio, in grado di fornire ai satelliti e alle astronavi prestazioni incredibili, la realtà invece è ben diversa. La tipologia di CPU più utilizzata per la ISS è l’Intel 80386SX, che equipaggiava i nostri PC domestici più di una ventina di anni fa, e il sistema operativo software maggiormente utilizzato è GNU/Linux.

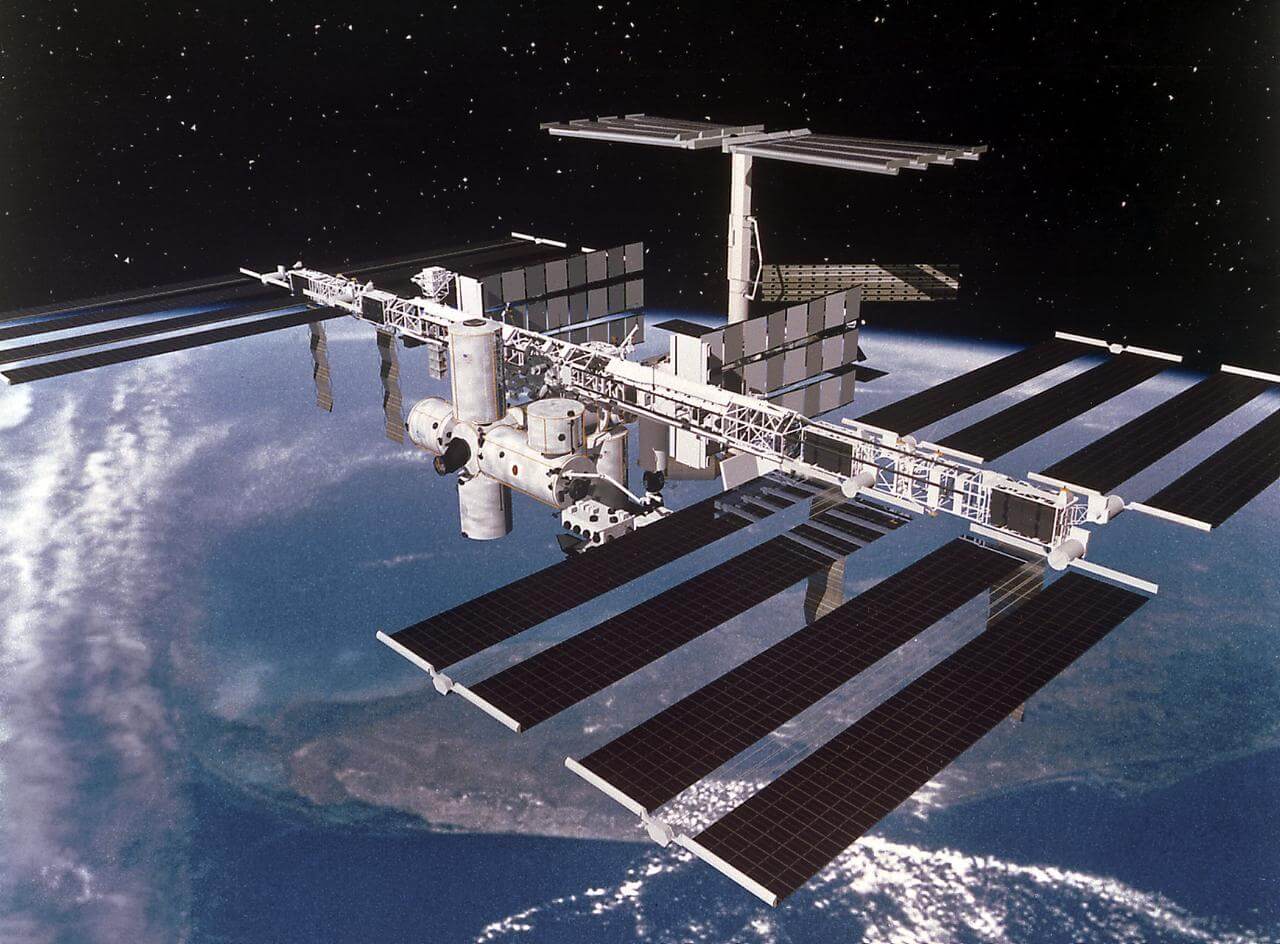

Foto: Nasa

Indice degli argomenti

I computer e le radiazioni cosmiche

Scoprire i vari tipi di radiazioni presenti nell’ambiente spaziale è stato fondamentale nella storia dell’elettronica spaziale, insieme alla comprensione di come queste radiazioni influiscono su di essa al fine di sviluppare idonee tecniche di indurimento e mitigazione del danno. Le principali fonti di questa radiazione sono i raggi cosmici, le particelle solari e le cinture di protoni ed elettroni che orbitano ai margini del campo magnetico terrestre, cioè le note cinture di Van Allen. Le particelle che colpiscono l’atmosfera terrestre sono composte per circa l’89% da protoni, per il 9% da particelle alfa, per l’1% da nuclei più pesanti e per l’1% da elettroni solitari. Però possono raggiungere energie fino a 1019 eV e quindi usando microchip non qualificati per lo spazio il disastro è praticamente certo.

Le radiazioni sono uno dei fattori chiave che i progettisti prendono in considerazione quando costruiscono dei computer spaziali, e quindi tra le varie tecniche di protezione è stata sviluppata quella dell’indurimento che è risultata essere una delle più efficaci. Per mitigare gli effetti delle radiazioni sono state implementate delle modifiche nel processo di fabbricazione dei microprocessori con una tecnica produttiva, nota come indurimento, che usava materiali come lo zaffiro o l’arseniuro di gallio che sono meno suscettibili alle radiazioni rispetto al silicio. Il risultato fornisce processori che funzionano molto bene in ambienti estremi come lo spazio, però richiedono linee progettuali e produttive dedicate, in pratica un’intera fonderia solo per realizzarli, e questo ha sempre influenzato i costi e i tempi in misura importante.

Per aumentare le prestazioni usando processori sempre più avanzati e soprattutto per mitigare i costi di una moderna fabbrica di semiconduttori, dato che le modifiche personalizzate per un mercato di nicchia come lo spazio erano sempre più costose, gli ingegneri hanno cominciato a utilizzare processori commerciali potenzialmente inclini a effetti radiativi passando a tecniche di indurimento alternative, in gergo “per progettazione. I chip RHBD (radiation-hardening-by-design) si basano sul processo di fabbricazione CMOS (Complementary metal-oxide-semiconductor) standard e possono essere fabbricati in fonderie commerciali, abbassando i costi e consentendo ai progettisti di missioni spaziali di recuperare prestazioni computazionali.

Lo Spaceborne Computer-2

Anche su questa strada hanno lavorato gli ingegneri della HPE per progettare i computer della serie “Spaceborne”, il cui primo esemplare ha volato nel 2017 a bordo dell’astronave Dragon della SpaceX e ha funzionato un anno e mezzo sulla ISS. I sistemi Spaceborne includono le piattaforme smart HPE Apollo 40 per archiviazione dati non strutturati, big data analysis e per carichi di lavoro ad alta intensità, con un’interconnessione HPC ad alta velocità che gira con un sistema operativo Linux open source. Per non apportare modifiche costruttive, gli ingegneri della HPE hanno creato un involucro unico raffreddato ad acqua per l’hardware e hanno sviluppato un software di sistema appositamente progettato per i requisiti ambientali e di affidabilità del supercalcolo nello spazio. In pratica, è stato realizzato un sistema RHBD con un software che protegge l’hardware: ad esempio durante un evento ad alta radiazione, il software abbassa la potenza, e quindi la velocità del computer, consentendo così nel complesso di realizzare un hardware più leggero e robusto utilizzabile nello spazio con prestazioni paragonabili a quelle dei supercomputer terrestri.

Infatti, già nel 2017 il primo Spaceborne Computer sulla ISS aveva raggiunto più di un trilione di calcoli al secondo, risultando fino a 30 volte più veloce di un normale laptop. Ora il secondo esemplare in rampa di lancio promette di superare il record e soprattutto di gettare davvero le basi per i computer fantascientifici che sinora si sono visti solo sul grande schermo. Infatti, è previsto che nel corso della missione di due-tre anni, Microsoft collegherà la sua piattaforma di cloud computing “Azure Space” allo Spaceborne Computer-2 per eseguire elaborazioni intensive e trasmettere dati da/per il computer spaziale. Così, si avrà il primo nodo spaziale di un cloud terrestre e da quel momento si apriranno davvero scenari fantascientifici.

Lo Spaceborne Computer-2

Le potenzialità del nuovo computer spaziale

Spaceborne Computer-2 sarà dotato di unità di elaborazione grafica (GPU) per analizzare in modo efficiente i dati ad alta intensità di immagini che richiedono una risoluzione maggiore, come le riprese delle calotte polari sulla terra o le radiografie mediche. Le capacità delle GPU supporteranno anche progetti specifici che utilizzano AI e tecniche di machine learning.

La combinazione dei vari miglioramenti dello Spaceborne Computer-2 permetterà agli astronauti di eliminare la latenza e i tempi di attesa più lunghi associati all’invio di dati da e verso la Terra, così da poter portare avanti la ricerca e ottenere insight immediatamente per una serie di progetti, tra cui:

- Monitoraggio in tempo reale delle condizioni fisiologiche degli astronauti elaborando raggi X, ecografie e altri dati medici per accelerare i tempi di diagnosi nello spazio.

- Analizzare grandi volumi di dati da sensori remoti. Ci sono centinaia di sensori che la NASA e altre organizzazioni hanno strategicamente posizionato sulla ISS e sui satelliti, che raccolgono enormi volumi di dati che richiedono una notevole quantità di larghezza di banda da inviare alla Terra per essere elaborati. Con l’in-space Edge computing, i ricercatori possono elaborare a bordo immagini, segnali e altri dati relativi a una serie di eventi, come:

- l’andamento del traffico, godendo di uno sguardo più ampio sul numero di auto sulla strada e anche nei parcheggi

- la qualità dell’aria misurando il livello di emissioni e altri inquinanti nell’atmosfera

- il monitoraggio degli oggetti che si muovono nello spazio e nell’atmosfera, dagli aerei ai lanci di missili.

Perché nello spazio orbitano computer obsoleti

Normalmente, si resta perplessi nell’apprendere che le prestazioni dei processori che gestiscono i computer della stazione spaziale non hanno nulla di moderno, e infatti la sfida per infrangere le barriere tecnologiche che ostacolano il supercalcolo rapido e affidabile nello spazio rappresenta uno dei temi più caldi di quel futuro prossimo in cui intelligenza artificiale e robotica sembrano essere funzionalità ormai inevitabili. Uno dei principali motivi per cui un computer spaziale è “obsoleto” quando arriva nello spazio è la durata del tempo necessario per crearne uno, a volte la NASA impiega un decennio per realizzarlo. Inoltre, ogni dispositivo è concepito per le caratteristiche tecniche necessarie alla missione progettata, il che rende il tutto aderente alle tecnologie del tempo contingente e non con quello delle operazioni. Senza contare che le CPU dei computer assorbono energia e nello spazio ogni watt conta in termini di budget disponibile, quindi l’aggiornamento in corso d’opera dell’hardware non è propriamente un’opzione che si contempla quando si progetta una missione spaziale. Nonostante un’astronave sia un veicolo molto complesso e sofisticato, il suo sistema di controllo hardware e software è abbastanza semplice e consiste in unità di base che possono eseguire un numero molto limitato di operazioni. Il motivo è chiaro: meno operazioni i moduli devono svolgere e più il sistema è stabile e affidabile, il che rende più facile risolvere i problemi che possono insorgere.

Anche il software spaziale è più “prevedibile”, infatti sono utilizzati sistemi operativi real-time che danno poco spazio alla “speculazione” informatica per garantire una risposta istantanea. Il sistema Windows, per esempio tende a effettuare molto buffering mentre i RTOS spaziali lo limitano al massimo e sono progettati per non sprecare le risorse di sistema, RAM o CPU che sia.

Un esempio pratico di ciò è il computing system di Curiosity, il Rover della NASA che dal 2012 circola sulla superficie di Marte: funziona con due processori BAE RAD750 con clock fino a 200 MHz, ha 256 MB di RAM e 2 GB di SSD. Poiché funziona da anni sul pianeta rosso, di fatto oggi è il meglio che si possa inviare nello spazio a milioni di chilometri dalla Terra e infatti anche il prossimo Rover della NASA, Perseverance, che sta per atterrare su Marte dispone del medesimo processore.

Però, rispetto allo smartphone che usiamo quotidianamente, le prestazioni del RAD750 sono ridicole, anche se poi tutti noi usiamo telefoni potentissimi principalmente per inviare messaggini di testo che pesano pochi kilobyte. Tornando al Rover marziano, la sua CPU è basata sul processore PowerPC 750 che IBM e Motorola introdussero alla fine degli anni Novanta per contrastare il Pentium II di Intel. Ciò significa che l’hardware spaziale tecnologicamente più avanzato che opera oggi nello spazio profondo sulla superficie del pianeta Marte può gestire senza intoppi un videogioco di trent’anni fa ma dal punto di vista computazionale non potrebbe reggere il carico di operazioni di un odierno videogame. Bene direte voi, ma allora perché non prendere un iPhone, inserirlo in un satellite o in un modulo della stazione spaziale e usarlo per operazioni complesse nello spazio? Dal punto di vista prestazionale, un iPhone è intere generazioni avanti rispetto ai RAD750 e costa solo un migliaio di dollari. Se si provasse a testare un iPhone in un acceleratore di particelle si potrebbe vedere come si comportano i suoi microchip quando sono esposti alle radiazioni simili a quelle solari che inondano lo spazio esterno all’atmosfera terrestre. Si guasterebbero. I circuiti sono estremamente vulnerabili alle alte energie e infatti non sono mai stati pensati né testati per computer da inviare nello spazio, quanto piuttosto per mezzi aerei e navali, anche militari, quindi intrinsecamente più resistenti, ma non in grado di sopportare le condizioni estreme dello spazio.