L’intelligenza artificiale sta conquistando sempre più device e sempre più aspetti della vita quotidiana. Dal centro, dai supercomputer in cloud, sta passando ai dispositivi che abbiamo nelle nostre mani. L’era dell’intelligenza artificiale nell’”edge” della rete, che non significa ai margini ma piuttosto al centro, prossima a noi, che lavora costantemente in contatto con il centro, con il cloud, per analizzare, decidere e rispondere alle nostre esigenze anche inconsapevoli.

Indice degli argomenti

Device: l’AI dal cloud all’edge

Apple ha annunciato che Siri processerà la nostra voce anche quando non richiesto, per avere la risposta alle nostre esigenze “più pronta” quando sarà chiamata in causa; Google e altri hanno scelto di produrre il proprio chipset o hardware per avere la possibilità di implementare la loro intelligenza artificiale e governare meglio l’evoluzione dei dispositivi.

L’AI la possiamo trovare anche nel più piccolo dei dispositivi o sensori, purché dotati di un processore e di una memoria, piuttosto che nelle auto attuali o di futura concezione.

Quello che sembra un vezzo, avere il proprio hardware, in realtà è proprio la strada per passare dall’AI nel cloud all’AI edge. L’edge computing è un’architettura IT distribuita e aperta, con potenza di elaborazione decentralizzata, predisposta per le tecnologie di mobile computing e Internet of Things (IoT).

Il perché ce lo dice il concetto di intelligenza stesso, ovvero un continuo processo di autoapprendimento e miglioramento dei propri algoritmi, magari anche con richiesta di maggiori prestazioni computazionali. Nel caso in cui l’AI sia posta al centro, vedi Alexa di Google, la base dati su cui auto-apprendere è enorme, è l’insieme di tutti i device che ne fanno uso. Questo rende più veloce tutto lo sviluppo e l’evoluzione del sistema ma, allo stesso tempo, vincola a una connessione sempre presente, a una condivisione delle esperienze e dei dati (anche se anonimi), e può più facilmente essere indirizzata da chi gestisce il sistema.

Avere l’AI tra le proprie mani, sul singolo device, allarga lo spettro di utilizzo, rende temporaneamente più difficoltoso lo sviluppo e l’aggiornamento (si pensi al firmware da aggiornare) ma, soprattutto, aumenta notevolmente la complessità del sistema perché ci saranno più “intelligenze” da far convivere e più device da seguire nella loro evoluzione. I vantaggi però promettono di essere enormi. Pensiamo a un’auto a guida autonoma, essa deve necessariamente funzionare anche senza la connessione alla rete dati. E soprattutto deve implementare algoritmi e sistemi non hackerabili, testati e ritestati, con chiara responsabilità etica e sociale sul risultato dell’applicazione degli algoritmi stessi.

Device, una questione di capacità di calcolo

Il passaggio dalla AI al centro a quella all’Edge non è solo un aspetto di dimensioni, di memoria e di base dati, è soprattutto una questione di capacità di calcolo e velocità della connessione dati. Nel cloud dei grossi player come Google, Apple, Amazon, IBM, Microsoft o altri, la capacità di calcolo può essere considerata infinita rispetto a quella che possiamo avere anche nel device più evoluto e potente oggi, lo stesso dicasi per la capacità di memoria. E la maggior parte degli algoritmi che silentemente ci aiuta durante il giorno utilizza queste capacità pressoché infinite.

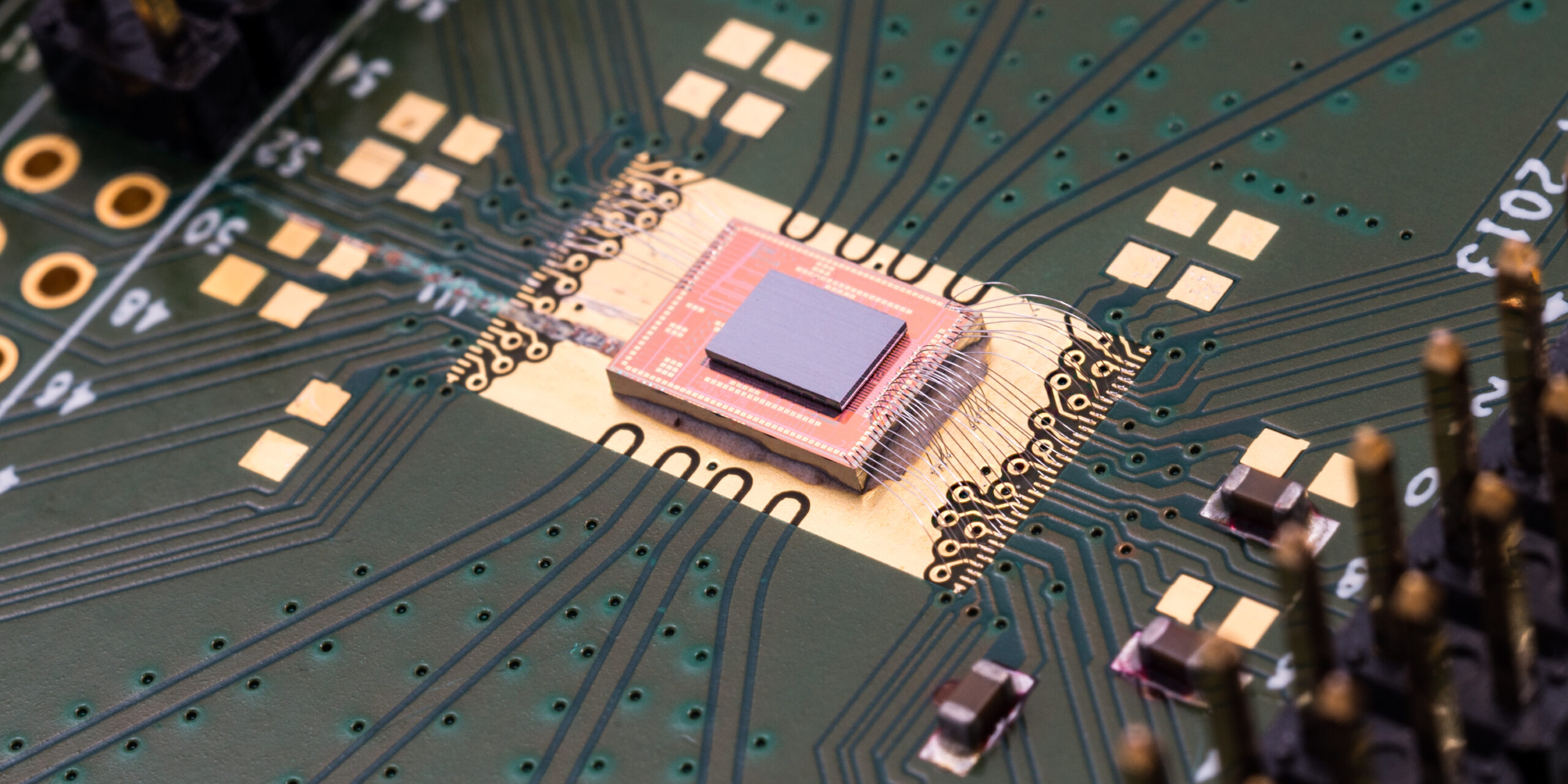

Si pensi ad esempio alla funzione di speach-to-test apparentemente semplice ma molto demanding in termini di risorse: pensare di averla solo in uno smartphone significherebbe tornare indietro di anni rispetto alla sua facilità di uso e correttezza di risposta. Ecco che nascono i processori neurali dedicati, ovvero chipset che assistono il processore principale con le istruzioni base per avviare il processo di autoapprendimento alla base di ogni intelligenza artificiale, pre-programmati e capaci di girare anche senza la connessione dati. Chip che possono essere poi assistiti e sincronizzati da intelligenze artificiali superiori in cloud che continuano il loro processo di evoluzione.

Si parla di stratificazione dell’intelligenza artificiale; ad esempio, nel caso di smartwatch con il sensore di battito o del livello di saturazione del sangue, quest’ultimo deve solo saper riconoscere gli eventi critici o i punti di trigger, come il numero di pulsazioni basse o poco ossigeno – primo livello di AI – per poi permettere all’applicazione su smartphone o PC o altri device di continuare l’analisi – secondo livello di AI – che a sua volta è costantemente aggiornata e assistita da una applicazione centrale in cloud – terzo livello di AI – che fa beneficiare a tutta la catena “app-smartphone-smarwatch” dei progressi che la scienza fa nello studio del monitoraggio dei battiti e della saturazione del sangue.

Conclusioni

Sembrano scenari futuristici, in realtà sono già entrati a pieno titolo nella nostra vita quotidiana, nelle industrie, negli oggetti definiti smart.

Se da un punto di vista tecnico la via sembra imboccata, la tecnologia è disponibile a un costo più che accettabile; da un punto di vista pratico si pongono problemi etici e legali di non facile risoluzione. Di chi è la responsabilità delle azioni intraprese da un dispositivo il cui algoritmo di autoapprendimento è stato lanciato anni prima e lasciato libero di evolvere? Chi ci assicura che le decisioni e le azioni prese siano sempre quelle corrette nel contesto di riferimento?

Su questi temi si stanno concentrando gli sforzi della comunità scientifica e non solo, è da queste risposte più etiche e legali che tecniche che noi tutti acquisiremo la fiducia necessaria a fare ulteriori passi nell’utilizzo dell’AI nella nostra vita.

È un percorso di avvicinamento a due: noi cerchiamo ausilio e supporto dai terminali, i quali imparano da noi, ma dobbiamo fare attenzione affinché non prendano il sopravvento perché, come nella vita reale, anche i device più intelligenti, se lasciati liberi di auto-apprendere e decidere potrebbero un giorno fare danni collaterali anche gravi. Danni fisici a persone e cose, danni finanziari, fino a, seppure involontariamente, commettere crimini.