Anche se la maggior parte dei dipartimenti It è tuttora impegnata nel consolidamento e nella virtualizzazione delle risorse server, storage e networking del data center, con attività che ne assorbono buona parte del budget e risultano prioritarie anche nel 2014, per il Cio che sa, come bisogna che sappia, guardare avanti, queste cose appartengono oramai al passato. Già da due d’anni, infatti, l’evoluzione del concetto di data center ha fatto una svolta e i responsabili dell’infrastruttura e delle operazioni si devono oggi focalizzare su un nuovo indirizzo di crescita di quello che per comodità continuiamo a chiamare centro dati ma che è di fatto la struttura abilitante dell’innovazione e dello sviluppo funzionale dell’It e, tramite questo, dell’impresa. Ossa, muscoli e nervi, se ci permettete la metafora, al servizio di una mente che sta nella logica delle applicazioni. Come i business manager puntano al cliente, così anche i responsabili del data center devono diventare ‘customer-oriented’, pensando a come servire al meglio i loro ‘clienti’, le applicazioni appunto (utilizzate, peraltro, dal vero cliente del data center, che sono i diversi utenti sparsi nelle Lob aziendali). Le applicazioni sono “clienti” esigenti: non accettano compromessi e tanto meno cadute sulla qualità del servizio: dev’essere del livello stabilito. E soprattutto quando è il loro turno vogliono essere servite subito, senza dover aspettare che le risorse siano pronte. Altrimenti è il business, l’attività dell’impresa, che ne risente. E questa è una cosa che nessuno, oggi più che mai, si può permettere.

Siamo quindi di fronte a un nuovo concetto di data center che si può definire in tre punti: centrato sulle applicazioni, definito dal software e predisposto al cloud ibrido. Application-centric per quello che abbiamo detto, Software-defined perché per un sistema capace di organizzare le proprie risorse via software è più facile ‘parlare’ con le applicazioni per eseguirne le richieste e sfruttare il potenziale di consolidamento delle risorse virtualizzate. E predisposto al cloud ibrido perché questa è la strada che si va delineando, con servizi pubblici di IaaS, più economici, sfruttati per lo sviluppo, il monitoraggio e il testing e servizi infrastrutturali privati, più sicuri per availability e protezione dei dati, sui quali dirottare alla bisogna le istanze delle applicazioni business in linea.

Interpretare le tendenze evolutive

Le tre tendenze evolutive del data center di cui s’è detto sono state colte per tempo, e talvolta anticipate, dai fornitori di tecnologia. Che le hanno interpretate in modi diversi nella loro offerta. Un po’ perché ciò è normale quando si tratta di cogliere fenomeni in atto e un po’ perché, com’è altrettanto normale, ciascuno vi ha risposto mettendo a frutto le capacità ed expertise proprie o acquisite allo scopo. Il risultato è un’offerta infrastrutturale che, pur partendo per la base hardware dalla radice comune dei blade server, presenta soluzioni diversificate le cui caratteristiche e soprattutto i cui pro e contro per chi intenda adottarle non sono facili da identificare.

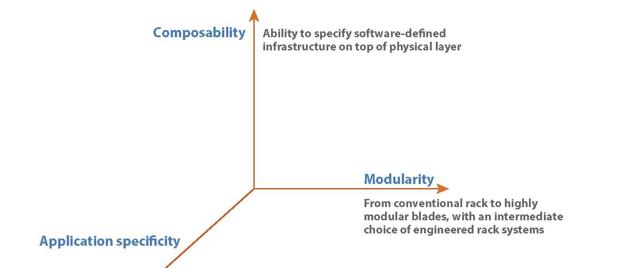

Ci ha provato Forrester Research, che in un recentissimo rapporto pubblicato nel settembre di quest’anno (Market Overview: Converged Infrastructure Solutions in 2013) ha proposto un criterio di classificazione applicabile ad ogni infrastruttura e basato su tre ‘dimensioni’: modularità, componibilità e specificità applicativa (vedi figura). La modularità è il livello al quale la soluzione proposta permette di gestire in modo unitario infrastrutture realizzate assemblando componenti fisici costituiti da telai (enclosure) con blade server assieme a moduli rack di tipo standard; è evidentemente un vantaggio in quanto indica la capacità di realizzare rapidamente l’infrastruttura desiderata, anche reimpiegando componenti preesistenti, e con la quale si può scalare aggiungendovi nuove risorse. È una condizione che quasi tutti i vendor soddisfano a un buon livello, anche quelli che assemblano elementi di diversa origine, facilitati in ciò dall’adozione di server ‘industry standard’ e di connettività quasi altrettanto standardizzate su Ethernet, FC e FCoE.

La componibilità è la capacità di organizzare un’infrastruttura costituita da elementi definiti via software, con risorse server, storage e di networking totalmente virtualizzate. È una condizione complessa da valutare in quanto gli elementi che definiscono una risorsa (tipo capacità, indirizzi fisici, identificativi utenti, bus di input/output e quant’altro) possono avere livelli di virtualizzazione diversi da una soluzione a un’altra: vuoi per motivi tecnologici (compatibilità tra l’hardware e la piattaforma di gestione delle virtual machine, se non sono dello stesso vendor); vuoi per motivi di partnership o acquisizioni tecnologiche, che per le soluzioni cui concorrono più vendor possono mutare, con cambiamenti nel prodotto; vuoi infine per motivi di strategia d’offerta (posizionamento sul mercato, pricing, differenziazione di gamma e così via), cause che, come è naturale, avvengono anche all’interno dell’offerta di uno stesso fornitore.

La specificità applicativa, o il ‘focus’ come lo chiama Forrester, indica il livello in cui l’infrastruttura modulare e virtualizzata si può considerare in grado di svolgere ogni impiego con la stessa efficienza e se è stata ingegnerizzata e ottimizzata per un campo specifico. Anche qui l’interpretazione di questa caratteristica è ampia: a un estremo dell’asse troviamo sistemi chiaramente ‘general purpose’ come gli originari blade server modulari e all’estremo opposto soluzioni come le Ibm PureApplication o le Oracle Exalogic che incorporano oltre alle risorse di infrastruttura anche le logiche applicative. In mezzo, per così dire, stanno i sistemi dedicati alla gestione dello storage e dei dati, sia perché database e data management non si possono collocare nell’area del software di base, ma nemmeno in quella applicativa; sia perché i confini tra la gestione dello storage (dominio infrastruttura) e quella dei dati (dominio database e middleware) sono, grazie appunto alla virtualizzazione, molto sfumati. Solo un’analisi delle capacità della singola soluzione, così come configurata dalle risorse e dagli strumenti di management scelti dall’utente, può dire a quale livello di focus sul dominio applicativo si possa collocare.

Secondo il livello al quale si collocano lungo le tre dimensioni che abbiamo descritto, si può tentare una classificazione delle nuove architetture infrastrutturali proposte dall’offerta (che analizzeremo dettagliatamente nell’articolo seguente) e indicare verso dove stanno evolvendo.

I tre modelli architetturali

Secondo il livello al quale si collocano lungo le tre dimensioni che abbiamo descritto, si può tentare una classificazione delle nuove architetture infrastrutturali.

-

Architetture convergenti modulari. Sono costituite da un insieme di elementi basilari (building block) che incorporano i sistemi di virtualizzazione degli elementi fisici (blade server) e delle loro connessioni. Anche i vantaggi sono quelli basilari: riduzione dei punti di connessione alla rete aziendale, riduzione del tasso di errori (assieme a un recovery più veloce in caso d’errore) e, in ultima analisi, riduzione dei costi operativi. Gli sviluppi di questo gruppo di soluzioni tendono ad espandere le funzioni base di virtualizzazione che ne facilitano il deployment nelle seguenti aree:

- Gestione centralizzata. Tutti i vendor hanno oggi ambienti federati che permettono di gestire più istanze consolidate su una console centrale. Bisogna però essere cauti nella valutazione dei vantaggi perché sebbene in generale tutti offrano capacità analoghe e riescano a ridurre i costi operativi migliorando l’efficienza del provisioning e della gestione delle patch e degli aggiornamenti, tra le singole soluzioni esistono differenze significative.

- Integrazione dello storage. Tutti hanno investito nel migliorare la capacità di gestire ‘pool’ di risorse storage esterne in rete in sintonia con i carichi di lavoro assegnati alle risorse di calcolo. Molti hanno anche potenziato capacità e throughput con lo storage interno.

- Upgrade verso il software-defined. C’è un’offerta di upgrade (opzionali e a pagamento) per creare una infrastruttura definibile via software, ma chi vi sia interessato deve avere la massima cura nel verificare che la soluzione proposta incorpori tutti gli elementi di cui ha bisogno, perché questi possono variare da fornitore a fornitore e da caso a caso.

- Soluzioni integrate per compiti specifici. Si tratta di ‘stack’ applicativi completi e preintegrati sia a livello hardware che software. Sono progettate per mettere in produzione l’utente finale e il gruppo It che lo supporta quanto più rapidamente possibile e fanno da piattaforma nel passaggio da un’organizzazione modellata su silos applicativi verticali a una orizzontale. Il valore offerto al cliente sta nella riduzione del tempo necessario per fornire agli utenti il servizio It richiesto e nella differenziazione a livello hardware, con risorse più o meno potenti a seconda della capacità del fornitore. Per i vendor che hanno la proprietà sia dell’hardware che del software, le soluzioni integrate hanno l’ovvia attrattiva di portare i clienti verso un rapporto privilegiato. D’altra parte, anche per l’utente la soluzione one-stop-shop ha i suoi vantaggi in termini di compatibilità, avalilability, tempo di implementazione anche se il rischio lock in può rappresentare un deterrente.

-

Architetture software-defined. Le soluzioni collocabili in quest’area permettono all’infrastruttura di agire sui propri componenti, fisici e virtuali, considerandoli come un gruppo unitario in quanto ne ‘vedono’ le interdipendenze. Così, ad esempio, un gruppo di risorse server e storage può essere associato a un database per diventare una web application, questa può essere fornita agli utenti con una sola operazione e i servizi applicativi definiti possono essere riutilizzati dall’azienda. È un mondo complesso, che però presenta tre tratti distintivi:

- Progettazione di applicazioni e servizi compositi. Queste soluzioni comprendono i tool necessari a definire i servizi e catalogarli in una library.

- Portale per il provisioning dei servizi. La scelta e il deployment dei servizi sono gestiti in un ambiente separato dalla loro progettazione, in modo da permettere agli utenti abilitati di creare copie dei modelli relativi alle infrastrutture memorizzate e usarli al bisogno. La separazione tra progetto e provisioning è una caratteristica importante e il livello al quale la soluzione può fornire immagini delle applicazioni e del sistema operativo fa la differenza tra le soluzioni.

- Storage management. È un’area sulla quale tutti i vendor sono focalizzati con soluzioni che potenziano la capacità di gestione.